文本挖掘的艺术之一:

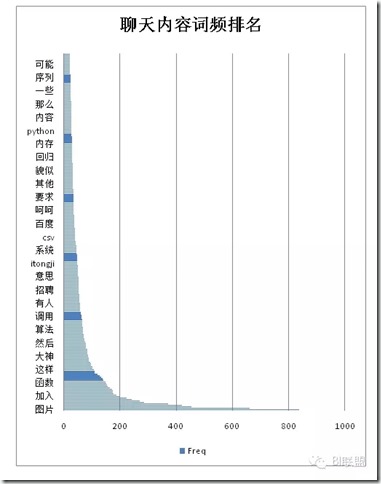

QQ聊天记录:中文聊天内容的挖掘

核心词云的制作:

![640_wx_fmt=png&tp=webp&wxfrom=5.webp[6] 令人称赞的 文本挖掘技术](http://www.liuhaihua.cn/wp-content/uploads/2015/07/ARzIz2.jpg)

在用R做文本挖掘之前我们需要做一些前期的环境准备,

我们这里做分析的文本是tm包下面的一个示例文本, 例如:

第一步:设置文本路径:

setwd("C://Users//aioger//Documents//R//win-library//3.2//tm")

第二步:建立自己的语料库:

ovid <- VCorpus(DirSource(txt, encoding= "UTF-8"), readerControl = list(language = "en"))

![640_wx_fmt=png&tp=webp&wxfrom=5.webp[8] 令人称赞的 文本挖掘技术](http://www.liuhaihua.cn/wp-content/uploads/2015/07/FfeIjif.jpg)

第三步:文档词项矩阵

dtm <- DocumentTermMatrix(reuters)

#词频关联查找:

findAssocs(dtm,"qui",0.3)

![640_wx_fmt=png&tp=webp&wxfrom=5.webp[10] 令人称赞的 文本挖掘技术](http://www.liuhaihua.cn/wp-content/uploads/2015/07/imm2uir.jpg)

第四:删除关联词频少的

dtm1<- removeSparseTerms(dtm,sparse=0.5)#这里是把关联性小于0.5的词给删掉

第五步:转正

data1<-t(t(dtm1))

data1<-as.matrix(data1)

data1<-t(data1)

对data1做中心化

data.scale <- scale(data1)

绘制聚类图

d <- dist(data.scale, method ="euclidean")

fit <- hclust(d,method="ward.D")

plot(fit,main ="文件聚类分析-王华")

![640_wx_fmt=png&tp=webp&wxfrom=5.webp[12] 令人称赞的 文本挖掘技术](http://www.liuhaihua.cn/wp-content/uploads/2015/07/yMBfea.jpg)

下面我们在来画出这个的词云图

v<-sort(rowSums(data1),decreasing=TRUE)

d<-data.frame(word=names(v),freq=v)

wordcloud(d$word,d$freq)

wordcloud(d$word,d$freq,scale = c(6, 1.5),min.freq = 2, max.words = 1000, colors = rainbow(100))

![640_wx_fmt=png&tp=webp&wxfrom=5.webp[14] 令人称赞的 文本挖掘技术](http://www.liuhaihua.cn/wp-content/uploads/2015/07/32yymeq.jpg)

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)