神经网络从被人忽悠到忽悠人(一)

为何取这标题呢,只是觉得目前人工智能只用于娱乐而已。

很早的时候就想写几篇关于人工智能的东西,把人工智能的东西写的通俗易懂点,但是毕竟人工智能的东西涉及的领域太广了,特别是对数学和概率有比较深的理解,如果只是想简单的了解,可以跳过文章的公式。

很难想象有什么事物会像廉价、强大、无处不在的人工智能那样拥有“改变一切”的力量。《必然》

前段时间的AlphaGo再次的把人工智能炒的火热,关于人工智能的讨论又再次进入讨论的风口浪尖上。各个方面对AlphaGo技术的猜测,神经网络也再次成为了技术的焦点。

一个看似简单的问题

给你一堆的图片,从图片中分出是猫,狗。归结成一个大问题:分类。本身来说,分类对计算机来说本该是最擅长的,本身0和1,就是很好的分类,编程语言的if else,swich,可以做到很好的分类。

像if else这种做法,似乎我们可以编写一套复杂的规则,这个规则覆盖所有的情况,就能够进行准确的分类了。但是这条路是走不通的,之前的自然语言处理就走过这条路。需要另外的选择一条出路。对,建模。通过模型来进行分类。

要让机器像人一样的思考,最好的办法就是让他的模型尽量的一样。莱特兄弟发明飞机时,并没有像之前一样利用翅膀,而是通过动力学原理。思考的机器如果靠的是规则下的专家系统,太过复杂,没有规律。最好的一条路是通过数学公式进行建模。

感知器

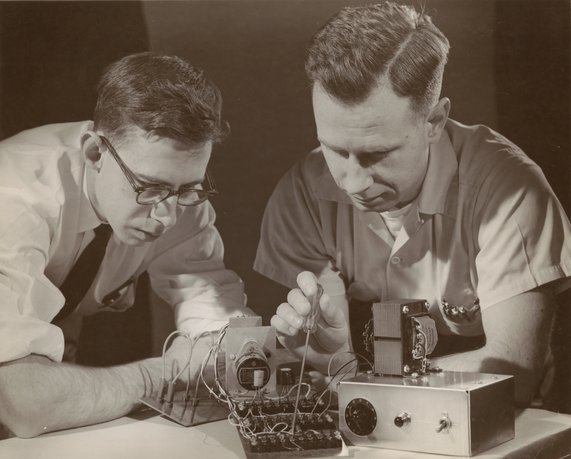

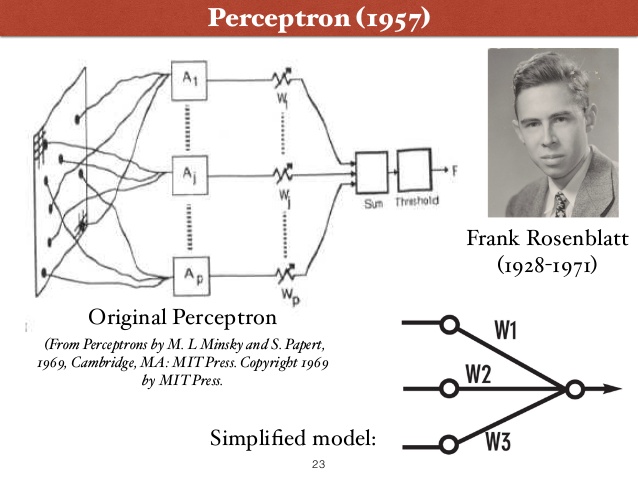

Hebb在1949年出版的《行为的组织》中,Hebb提出了其神经心理学理论。Hebb认为神经网络的学习过程最终是发生在神经元之间的突触部位,突触的联结强度随着突触前后神经元的活动而变化,变化的量与两个神经元的活性之和成正比。之后人们相继提出了各种各样的学习算法。康奈尔航空实验室心理学家Frank Rosenblatt 受到这种思想的启发,认为这个简单想法足以创造一个可以学会识别物体的机器,在1956年,创建了算法和硬件。1958年,Frank Rosenblatt在《 New York Times 》上发表文章《Electronic ‘Brain’ Teaches Itself.》,正式把算法取名为“感知器”。

1957年,Frank Rosenblatt 发布了算法模型:

1958年夏,Frank Rosenblatt受到美国海军的经费自助,并召开新闻发布会。《纽约时报》抓住了发布会的要点:

「海军透露了一种电子计算机的雏形,它将能够走路、说话、看、写、自我复制并感知到自己的存在……据预测,不久以后,感知器将能够识别出人并叫出他们的名字,立即把演讲内容翻译成另一种语言并写下来。」

现在来看这段话,就能看出Frank Rosenblatt靠谱的预见性了。可是这些事情在当时看来远超人们的想象,认为Frank Rosenblatt天方夜谭,像小孩子一样想象着未来。

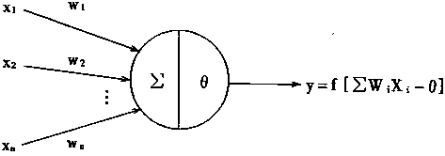

感知器是有单层计算单元的神经网络,由线性元件及阀值元件组成。感知器如图所示。

再来看 神经网络的学习过程最终是发生在神经元之间的突触部位,突触的联结强度随着突触前后神经元的活动而变化,变化的量与两个神经元的活性之和成正比。 Frank Rosenblatt用数学的方法描述这个过程。

感知器的数学模型:

Y=f(/sum_{m=0}^/infty W_iX_i - /theta) 其中:f[.]是 阶跃函数 ,并且有

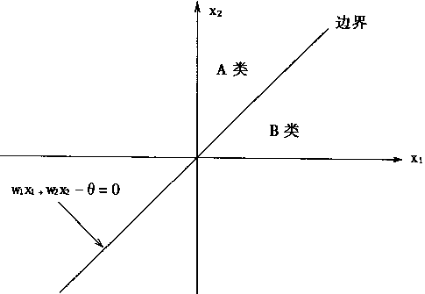

f(u) = 1,u=/sum_{m=0}^/infty W_iX_i - /theta/geq0 f(u) = -1,u=/sum_{m=0}^/infty W_iX_i - /theta/le0 θ是阀值。感知器的最大作用就是可以对输入的样本分类,故它可作分类器,感知器对输入信号的分类如下(A类,B类):

Y = 1,A Y = -1,B 当感知器的输出为1时,输入样本称为A类;输出为-1时,输入样本称为B类。从上可知感知器的分类边界是:

/sum_{m=0}^/infty W_iX_i - /theta=0 在输入样本只有两个分量X1,X2时,则有分类边界条件:

/sum_{m=0}^2 W_iX_i - /theta=0 即

W_1X_1+W_2X_2 - /theta = 0 也可写成

X_2=-/frac{W_1}{W_2}+/frac{/theta}{W_2} 这时的分类情况如图所示。

感知器算法

感知器的学习算法:目的在于找寻恰当的权系数(W1…Wn),使系统对一个特 定的样本(X1…Xn)能产生期望值d。

感知器学习算法 步骤 如下:

- 对权系数置初值。

- 输入一样(X1…Xn)本以及它的期望输出d。

期望输出值d在样本的类属不同时取值不同。如果是A类,则取d=1,如果是B类,则取-1。期望输出d也即是教师信号。 - 计算实际输出值。

Y = F[/sum_{m=0}^/infty W_iX_i - /theta] - 根据实际输出求误差e。

E = d-Y(t) - 用误差e去修改权系数。

W_i(t+1) = W_i(t)+/eta e X_i i=1,2...n,n+1 - 转到第2点,一直执行到一切样本均稳定为止。

感知器是整个神经网络的基础,神经元通过激励函数确定输出,神经元之间通过权值进行传递能量, 权重的确定根据误差来进行调节 (这个就是学习的过程),这个方法的前提是整个网络 是收敛 的。这个问题,1957年Frank Rosenblatt证明了这个结论。或许这才是开始

但是1969年,Minsky 和Papert所著的《Perceptron》一书出版,该书从数学角度证明了关于单层感知器的计算具有根本的局限性,指出感知器的处理能力有限,甚至连XOR这样的问题也不能解决,并在多层感知器的总结中,论述了单层感知器的所有局限性在多层感知器中是不可能被全部克服的。神经网络进入了萧条期。

Marvin Minsky是“人工智能之父”,1970年,Minsky获得了计算机科学界最高奖项——图灵奖(the Turing Award),同时他也是第一位获此殊荣的人工智能学者。2016 年1月24日,上帝着需要人工智能,带走了Marvin Minsky,享年89岁。

这才是开始,2004年IEEE Frank Rosenblatt Award成立,Frank Rosenblatt被尊称为神经网络的创立者。

这才是开始,2004年IEEE Frank Rosenblatt Award成立,Frank Rosenblatt被尊称为神经网络的创立者。

神经网络开启了人类对大脑的模拟形式,一种新型对大脑的建模,在这条路上后续有更多的科学家前仆后继,我们是树下乘凉的人。

神经网络开启了人类对大脑的模拟形式,一种新型对大脑的建模,在这条路上后续有更多的科学家前仆后继,我们是树下乘凉的人。

(未完待续)

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)