HBase完全分布式安装以及Hive远程模式(mysql作为数据库)的安装

各位真的不好意思。上次的博文有误。上次的应该是HBase的伪分布式安装。这次本人保证是完全分布式安装。

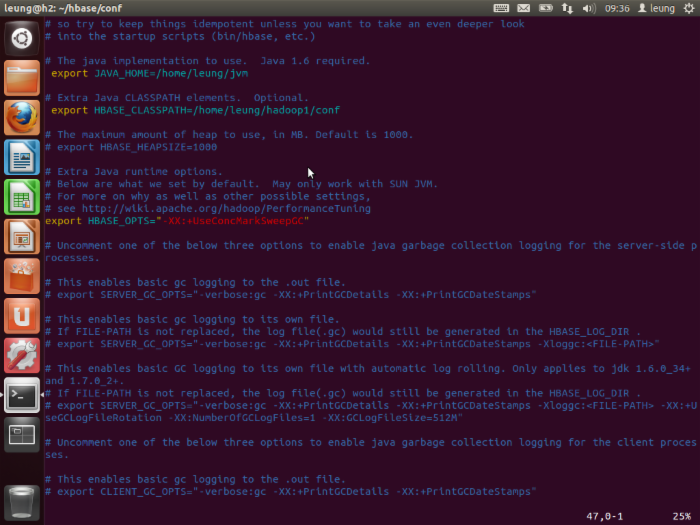

首先是 HBase的完成分布式安装。 这次部署的环境是hadoop-1.2.1+hbase-0.98.X。因为这个版本的HBase是直接对应hadoop-1.2.1,故也就省去了覆盖jar包的步骤以及排除了覆盖带来的不稳定性。OK,下载后解压,进入conf目录,配置hbase-env.sh文件。如图。这里HBASE_CLASSPATH是指向hadoop的conf目录的,这点需要注意。

下面是打开zookeeper。

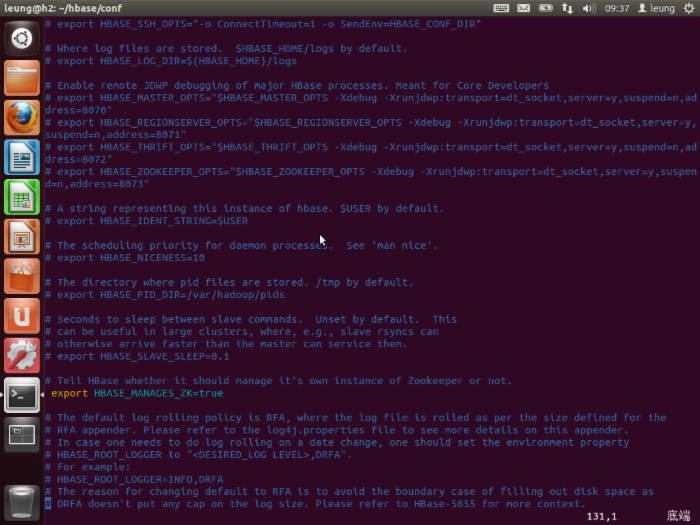

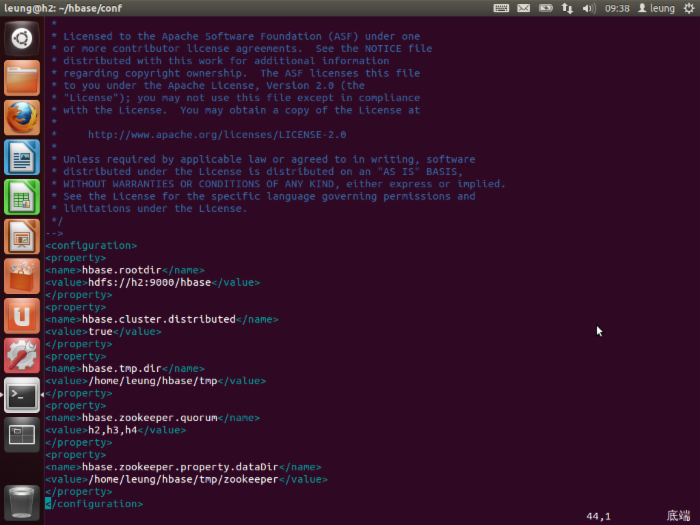

接下来是配置hbase-site.xml。这里的HDFS文件系统中的hbase目录需要新建。然后最后两个属性分别是指定zookeeper的几个节点和存放数据的目录。

最后是配置regionserver。HMaster是h2,regionserver是h3,h4.

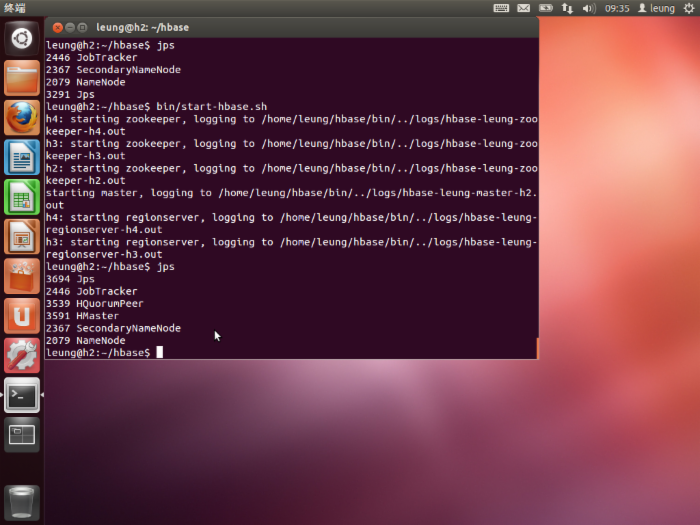

启动HBase。在这之前,需要确保hadoop已经启动!

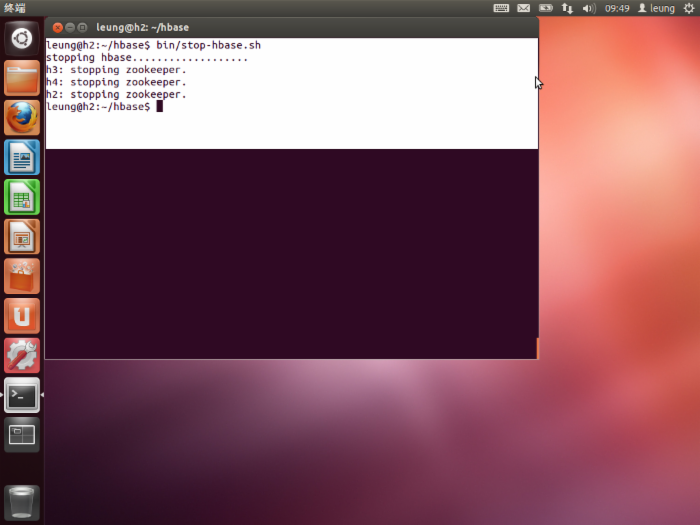

接下来是关闭hbase。

下面是 Hive的远程模式的安装(mysql作为元数据库) 。这里搭建的环境是hadoop-1.2.1+hive-0.12.0。

首先是下载hive解压,进入conf目录。将hive-env.sh.template复制成hive-env.sh。然后配置如下选项。

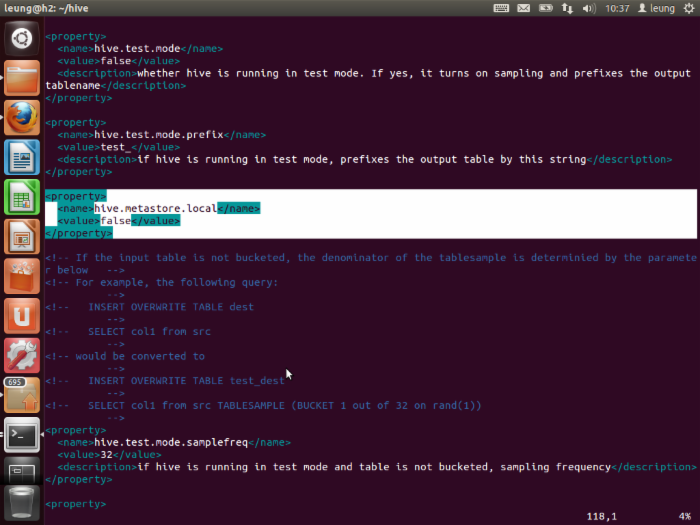

第一个是HADOOP_HOME=/home/leung/hadoop1(这是根据你安装hadoop的目录决定);第二个是HIVE_CONF_DIR=/home/leung/hive/conf(这是根据你的hive目录位置决定)。下面是将hive-default.xml复制成hive-site.xml。然后配置几个属性。如图。首先是改变metastore.local属性,改成false。

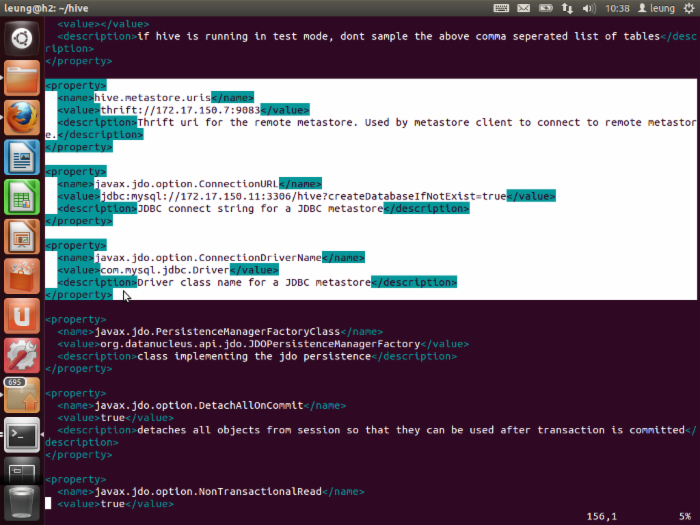

首先是指定mysql位置,然后是本机thrift,最后是jdbc driver名字。

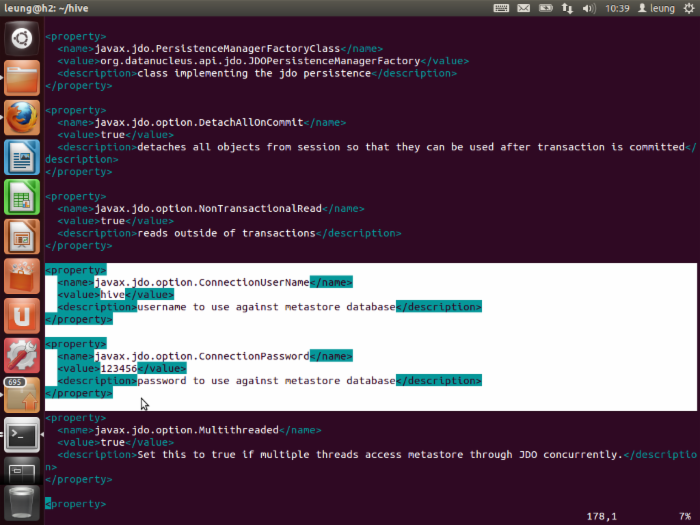

指定连接mysql的用户名和密码。这个用户必须首先在mysql中新建并赋予一定的权限!

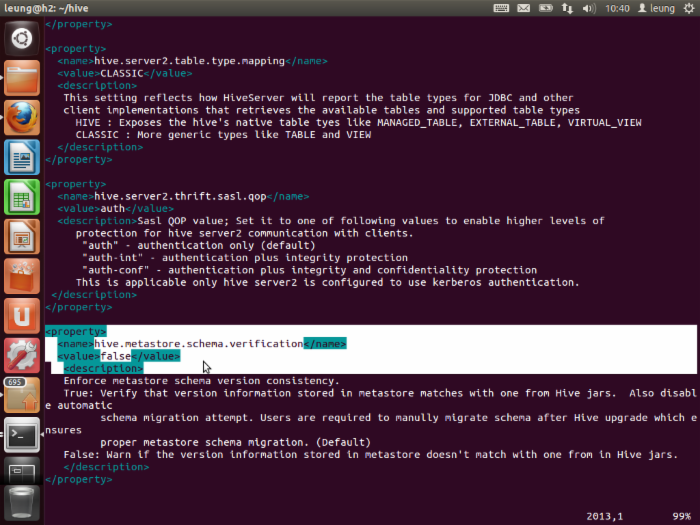

最后是将下面这个属性设置为false。同时需要注意的是这个文件大概2000行左右的地方有一个错误,是将</value>写成了</auth>。大家安装的时候发挥一下小宇宙啦,找找。

ok。配置完了可以启动了。首先是启动元数据库:hive --service metastore & ;然后是启动hiveserver: hive --service hiveserver &。之后,就可以正常启动hive了。

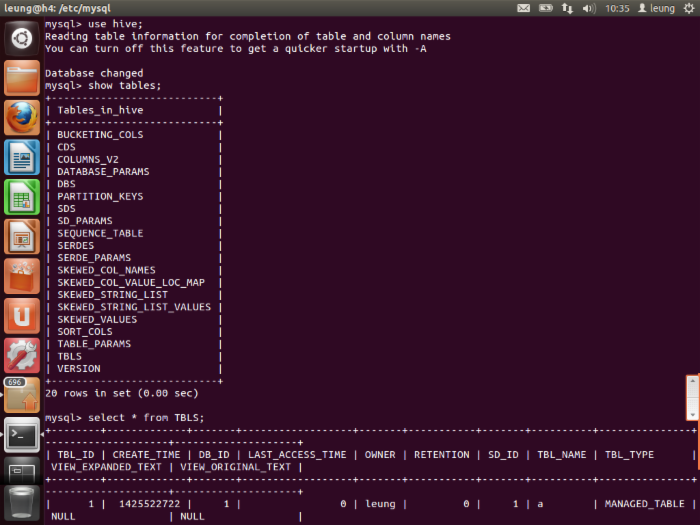

同时,我们到另外一个节点上看看数据库有什么变化。

可以看到原来空的hive数据库多出了这么多的表。这些都是hive启动之后创建的,以及我们查询TBLS表可以看到在hive新建表a的信息。

至此,HBase以及Hive都安装成功了!

谢谢大家!本人水平有限,请大家不吝指正!

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)