Yann LeCun 谈对抗性网络:如何让机器掌握常识?

众所周知, Facebook 开始采用人工智能技术的时间较早,使用频率也越来越高。现在,他们的研究人员正试着将这一技术带入下一个阶段——从纯数据处理逻辑迈向堪与人类媲美的某种形式的「常识」。虽然人工智能可以帮助机器实现很多事情,但是,完成这些基本任务所依赖的学习算法不仅要靠人类编写,也需要人类给系统输入海量训练数据,这一过程也就是我们常说的机器学习。机器要真正掌握常识,也就是说,可以根据尝试搞清楚世界的运作方式并作出合理决定,那么,它们必须能够自学,无需人类监督。虽然不可能很快实现这一点,不过,研究人员正在朝这个方向努力。不久前,Facebook 的 Yann LeCun 和 研究工程师 Soumith Chintala 介绍了他们在这方面取得的一些进展:对抗性训练(adversarial training)技术。LeCun 认为,人类需要和机器以一种非常自然的方式互动,因此,我们需要让机器懂得人类。易言之,机器需要掌握常识。

人类的学习过程,就是对现实世界进行观察和体验。或许在不久未来,会出现一部彻底(complete)的人工智能系统,不仅能识别文本和图像,还能进行更高级别的推理,预测,规划等,思考和行为方式可与人类相媲美。要掌握这类常识,机器需要一个内在模型,告诉它世界的运行方式,这就要求机器具备预测能力。现在我们所欠缺的就是:无需人类劳师动众地加以训练,机器自己可以建构起这样一个内在模型。

人类的大脑非常善于预测。比如,笔掉了,我们知道它会掉在地上,无需计算就知道如何接球。最近,对抗网络(adversarial networks )已经成为一个训练机器预测能力新方法,简单地通过观察就能进行预测。一个对抗网络带有一个发生器(generator),从随机输入中生成某类数据(比如,图片)。还带有一个判别器(discriminator),它从发生器中获取输入,或者从一个真实数据组中获取输入,判别器必须区分来源不同的输入——判别真伪。两个神经网络能实现自身优化,从而生成更加真实的输入,以及世界观更为合理的网络。

不过,人们以前认为,生成式对抗网络(generative adversarial networks)不稳定。有时,发生器压根儿没开始学习,或生成我们认为好的结果。在FAIR,我们已经发表了一组论文,与合作伙伴一同研究如何稳定对抗网络,我们从图像生成器开始,使用了 拉普拉斯对抗网络 (LAPGAN), 深度卷积生成式对抗网络 (DCGAN) ,接着是更为复杂费力的视频生成,使用了 对抗梯度差损失预测器 (AGDL)。不论我们给这些系统输入什么类型的图像或视频,他们都能开始学习,并预测出合乎情理的情景。

深度学习和卷积神经网络

在计算机视觉领域,基于监督数据集进行图像识别,卷积神经网络(CNN)一直很成功,但是,无监督表征学习却迟迟没有进展。原因之一就是我们不知道这个「黑盒」里发生的事情,而且我们想要理解每种算法的目的。

利用深度学习技术,我们可以单独训练系统各层级,并开发出具有更加复杂理解能力的深层结构,理解范围从物体边缘、完整物体再到各种情景。深度学习方法可被用于图像生成。但指的不是这样的系统:输入一张图片,然后告诉你是狗还是飞机,而是倒过来: 输入一串描述内容的数字,然后生成相应图像。

对抗训练比较复杂,因为我们不得不同时优化图像生成器和鉴别器。这就像是在寻找一处隘口;两座山峰之间最低处,同时也是两个山谷之间的最高点。这类优化比较困难,而且如果模型不稳定,我们就无法找到这个中心点。

虽然之前使用 CNN 训练生成式对抗网络的尝试都失败了,但是,当我们修改 CNN 结构去创造 DCGAN 时,我们就能将网络每层学习的滤波器可视化,也因此打开了黑盒。

对抗网络的性质

简单说来,在一个对抗网络中,判别器的输出就是:遇到真实图片,输出 1;如果是生成图片,输出 0。判别器想要做好这项工作,因此,它会优化自身,防止被生成器欺骗。反过来,生成器也正在优化自己,它想生成非常真实的图像,尽可能地迷惑鉴别器,让其难辨真伪。最后,生成器开始生成非常真实的图片:无论图片是生成器生成的还是真实的,半数时间里,判别器的正确概率都是恒定的。

这种对抗训练过程与传统神经网络存在一个重要区别。一个神经网络需要有一个成本函数,评估网络性能如何。这个函数构成了神经网络学习内容以及学习情况的基础。传统神经网络需要一个人类科学家精心打造的成本函数。但是,对于生成式模型这样复杂的过程来说,构建一个好的成本函数绝非易事。这就是对抗性网络的闪光之处。对抗网络可以学习自己的成本函数——自己那套复杂的对错规则——无须精心设计和建构一个成本函数。

实践中,对抗网络的这种特性可以转化为一些更好、更敏锐、质量更高的预测模型。为了展现这一点,我们用各种图片数据组训练了 LAPGAN 和 DCGAN , 这些图片要么采集了 ImageNet 数据组中一组特定图像,比如脸部,油画,卧室等,要么采集了一套各种自然景观图像。在人工智能社区,特别是 DCGAN ,开始变得很流行。几个研究人员根据我们为 DCGANs 公布的代码,用各种不同图像集训练了其他的 DCGAN。比如, 以下就是 NVIDIA 研究人员用18世纪的画作训练的一个 DCGAN。

我们已经见识过了无需任何监督,接受大型数据集训练就可以学会深度结构的 DCGAN 。当我们使用训练过的判别器,在其他数据组上完成图像识别任务时,DCGAN 的表现至少与其他无监督训练模型持平,甚至更好。我们也已能够将 DCGAN 在每层学到的滤波器可视化,也能经验地展示,神经网络已经学会如何根据学到的表征来绘制特定物体。比如,在卧室图像集中,当我们从生成器输入中移除「窗户」的表征时,神经网络通常会用其他诸如门或电视之类的表征取代它, 这意味着,它能够分清情景表征( scene representation)和物体表征( object representation)。

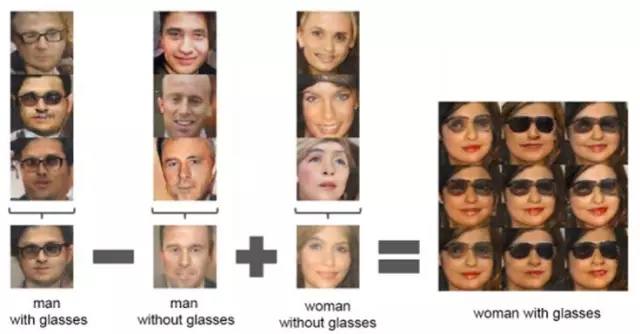

在某种维度空间内,DCGAN 也能够识别模式并将某些相似表征放在一起。比如,在脸部图像数据集中,生成器不理解什么是微笑的意义,但是,它能发现人类微笑图片的相似性,并将它们分为一组。基于之前使用文本做过的类似研究,我们调查了简单算术是否可以揭示出这一维度空间中的丰富关系。我们发现,通过求三个范例的平均值,可以得出连续,稳定的结果,在语义上遵守了算术规则。

无监督生成式模型学习目标特征

更聪明的机器

一旦我们可以训练一台机器去预测世界看起来什么样,那么,我们就能将机器学到的内容用于完成不同的任务。如果我们拍了两张照片,拍摄其中一张照片时,相机轻微左移以获取不同的拍摄视角,机器就会发现两张照片的不同之处,还会知道世界是三维的。然后,它会将这个知识应用到新的情景中,比如,够到桌子另一头的钢笔,距离有多远。当机器掌握了这个常识后,就会更善于找到最佳办法去完成某件特定任务,而且还能迅速拒绝其他任何不合常理的假设,比如,不开门就走出去。最终,这类知识会进一步加快应用研发,包括看先进的聊天机器人和虚拟助手。

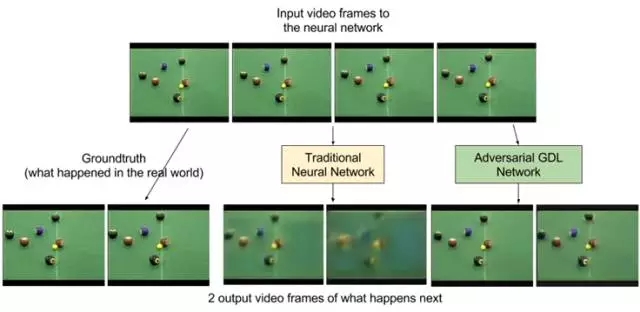

我们的AGDL研究,正朝着这个方向——预测将要发生的事情——在前进。我们选取了几帧视频然后打造模型进行预测。比如,桌球游戏,球被击中后,预测关于球的运动情况的下一帧内容。

虽然 ADGLs 已经向视频预测迈出了重要的第一步,但是,在我们开始根据这些模型预测进行推理并使用他们进行规划之前,仍然需要对当前模型进行改善,让它能够进一步预测未来。对抗网络,为打造具有诸如常识之类特点的无监督学习模型提供了一个强大的计算框架,而且我们也相信,在这个方向上继续探索和推进研究,就有可能成功打造出更加聪明的人工智能。

欢迎加入本站公开兴趣群

商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)