深度视觉盛宴——CVPR 2016

小编按:

计算机视觉和模式识别领域顶级会议CVPR 2016于六月末在拉斯维加斯举行。微软亚洲研究院在此次大会上共有多达15篇论文入选,这背后也少不了微软亚洲研究院的实习生的贡献。大会结束之后,小编第一时间邀请参与了本次大会的张弛、张婷和张祥雨三位同学,与我们分享了他们眼中的CVPR大会。参加CVPR大会是一种什么样的体验?CVPR论文是如何写成的?看完你就知道!

作者简介

张弛(论文: Joint Multiview Segmentation and Localization of RGB-D Images Using Depth-Induced Silhouette Consistency。 Chi Zhang, Zhiwei Li, Rui Cai, Hongyang Chao, Yong Rui )

我叫张弛,是一名微软亚洲研究院实习生,本科毕业于中山大学,目前是中山大学和微软亚洲研究院联合培养博士生。曾在CVPR/ICCV/ECCV/TVCG等会议和期刊上发表论文,研究方向为立体视觉匹配和即时定位与地图构建(SLAM)。

张婷(论文:① Collaborative Quantization for Cross-Modal Similarity Search, Ting Zhang, Jingdong Wang. ② Supervised Quantization for Similarity Search, Xiaojuan Wang, Ting Zhang, Guo-Jun Qi, Jinhui Tang, Jingdong Wang)

我叫张婷,本科毕业于中国科大少年班学院学习计算数学专业,曾参与微软亚洲研究院创新人才学院(Pre-PHD)培养项目,目前是中国科学技术大学和微软亚洲研究院联合培养博士生,在微软亚洲研究院实习。曾在ICML 2014/CVPR 2015/CVPR 2016发表论文,主要研究方向为近似最近邻搜索。

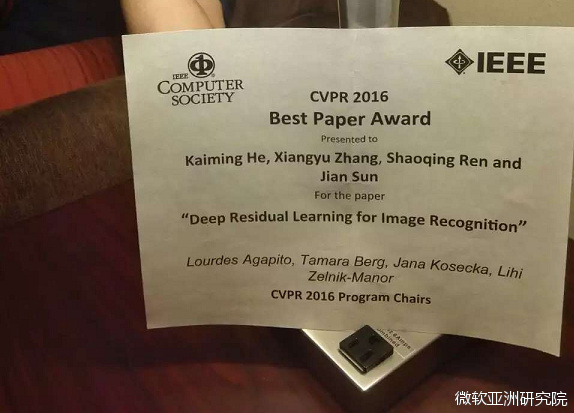

张祥雨 (论文: Deep Residual Learning for Image Recognition, Kaiming He,Xiangyu Zhang, Shaoqing Ren, Jian Sun )

我叫张祥雨,本科毕业于西安交通大学。三年前我参加了西安交通大学与微软亚洲研究院的联合培养博士生项目,一直实习至今。我的研究方向为深度学习与图像识别相关问题。

顶级视觉盛会

CVPR全称为International Conference on Computer Vision and Pattern Recognition,计算机视觉及模式识别大会。涵盖的问题包括但不限于:物体识别与检测、图像高级语义理解、人脸、优化方法、Correspondences求解、相机定位及三维地图构建(SLAM)。CVPR是计算机视觉的最大的年度聚会,今年收到投稿2,145份,接受论文643篇,接收率29.9%。与会人数也是惊人,达3,600人。去年是2800多人,今年有3609人,接近了30%的增长,这与计算机视觉在学术界和工业界得到越来越多的关注不无关系。毫无疑问,在这643篇接收文章中,深度学习再次占据了大半壁江山。

与往届不同的是,今年的CVPR增加了一种新的论文展现形式——Spotlights,有123篇优秀文章(Spotlights)拥有机会进行4分钟在听众面前宣讲他们的工作。在会议的Poster部分,所有文章的作者也可在自己的展板前与其他与会者进行面对面的交流。

今年的CVPR还有许多精彩的创新之处:

CVPR 2016展示了计算机视觉和深度学习领域最新的成就,包括像热门的大型视频理解和新兴的视觉问答领域问题。

有史以来第一次,CVPR 2016举办了一个100个公司参加的工业展。

同样有史以来第一次,CVPR 2016的组委会成员几乎全是女性。

仍然有史以来第一次,CVPR 2016选出了每天的亮点,与报告者的互动提问,介绍女性研究者等等,然后每天以简报的形式推送给大家。

如日中天的深度学习

本次会议张祥雨同学分享的关注点主要在深度学习和图像识别方面。深度学习作为眼下最热门的机器学习框架,其在计算机视觉方面的研究和应用可谓是如日中天。据不完全统计本次会议60%以上的文章均与深度学习有关。在图像识别,尤其是图像(视频)分类、物体检测、图像语义分割等领域,深度学习已呈一统天下之势。即使是在如3D视觉、底层图像处理等传统方法相对主流的领域也有不少学者给出了自己的基于深度学习的解决方案。

图像识别

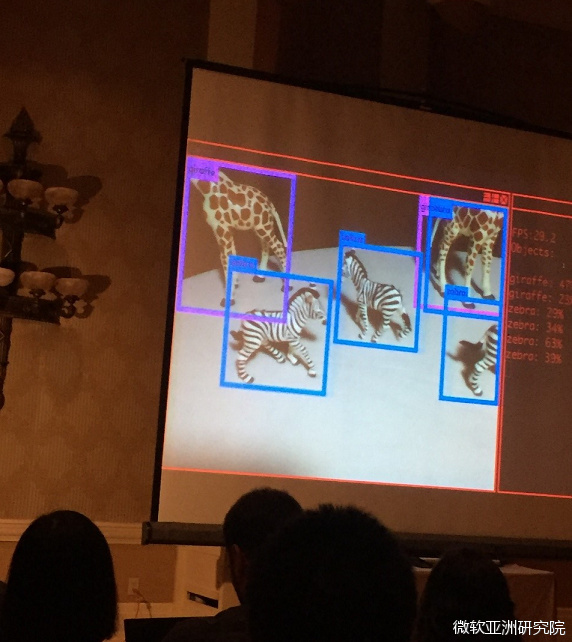

自从Ross Girshick等人提出基于深度卷积神经网络的物体检测方法“RCNN”以来,深度学习凭借着良好的精度逐渐成为物体检测的主流方法。之后的重要工作如“Fast RCNN”和“Faster RCNN”等更是将物体检查的准确度和速度均提升了一个档次。本次会议有5篇物体检测方面的工作进行了口头展示。其中,Abhinav Shrivastava等人在训练检测网络时通过添加困难样本,以一种非常简洁的方式取得了可观的性能提升,令人印象深刻;而在另一项工作“YOLO”(You Only Look Once: Unified, Real-Time Object Detection)中,演讲者Joseph Redmon通过幽默的语言和生动的现场展示,介绍了他们是如何设计算法框架以同时满足高精度和高实时性的要求。值得一提的是,Ross Girshick本人在这两个工作中均有贡献,足见其在物体检测领域“超级大牛”的地位。

作为图像识别问题的重要分支,图像语义分割(Semantic Segmentation)同样吸引了一批顶尖科学家投入研究。张祥雨所在的微软亚洲研究院视觉计算组通过对图像分割问题中的多个目标函数进行级联式的联合训练,在MS COCO等数据集上取得了明显的性能提升。该项工作是去年ImageNet & MS COCO比赛中微软冠军团队技术体系中的重要一环。此外,视觉计算组的另一篇有关图像语义分割的文章Scribble Sup: Scribble-Supervised Convolutional Networks for Semantic Segmentation也在会议上做了口头展示。

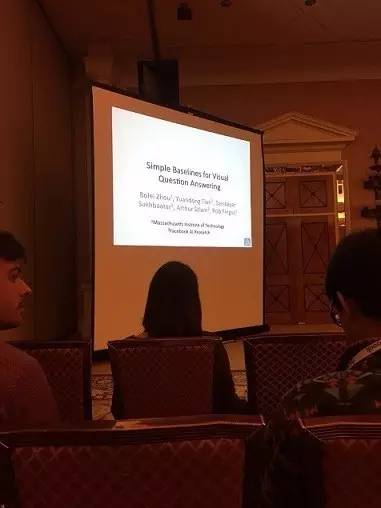

视觉问答(VQA)

视觉问答是近年来迅速兴起的研究课题。该问题的一般提法为:给定一张图片,以及一句使用自然语言描述的和图像相关的问题,视觉问答系统需要对该问题做出回答。可见,该课题同时涉及了图像识别和自然语言理解,更具挑战。而近年来深度神经网络在图像识别和自然语言处理的迅猛发展,为解决视觉问答问题提供了重要的思路。本次会议上视觉问答相关的文章几乎都采用了深度学习的方法。

值得一提的是,今年年初的视觉问答挑战赛(VQA Challenge)的比赛结果也在本次会议的视觉问答专题会议上公布。Yuandong Tian (田渊栋)等一批著名科学家被邀请在讨论会上发言。本次比赛设有4个挑战项目,共有20多支队伍参加角逐。张祥雨表示:“颇感荣幸的是,本次比赛所有项目的前三名均使用了我们发表的152层深度残差网络作为图像特征的提取模型,再次表明了我们的方法在不同的应用场景下均具有较强的推广能力。”

灵感碰撞的专题研讨会

今年的主讲嘉宾请来了神的平方级人物Amnon Shashua教授。Ammon是耶路撒冷大学的教授以及Mobileye公司的创始人。Ammon在会上给同学们分享了他对自动驾驶、深度学习、汽车市场的一些见解。

Keynote刚开始,Ammon老师就说出了这样一句话:

It’s not going to be the kindof talk that I’ll tell you how things are done. I’ll tell you that something more interesting is what are the things that need to be done. I always tell my students that 80% of the work is knowing what to solve. The remaining 20%percent, if you don’t do it, somebody else will do it. Knowing what to solve isreally the big thing.

“找到需要去做的东西去做才是最重要的”,此话让人深有感触。计算机视觉经过磕磕碰碰几十年的发展来似乎终于找到了靠谱的落地方式:无人车。主题演讲中Ammon将自动驾驶中的技术分为三个支柱,分别是传 感技术(Sensing),地图绘制(mapping)和驾驶策略(Driving Policy)(Planning) 。Ammon用一些例子说明了三个问题的发展状况,以及讨论了为何这三个问题必须同时发展并作为整体来考虑,以免一个问题对另一个问题产生分歧。在现在全世界一窝蜂想搞无人车的大环境下,AmmonShashua教授的演讲为想了解和想进入这个领域的同学们提供了一个很好的全局观,让大家理清了需要解决的问题,以及对这些问题的感性认识。

CVPR 2015曾有个专题研讨会:计算机视觉中的女性研究者(WiCV2015: Women in Computer Vision)。而今年CVPR 2016的组委会几乎全是女性,通过邀请在这个行业中的女性榜样研究员提高女性研究者的影响力和被关注程度。同时每天大会的简报还特意挑选出一两位女性研究者来分享她们关于研究兴趣、职场规划的宝贵经验,也给予年轻的女性研究者更多的机会去展示她们的成果。

张婷同学说:“在经过一周参会的思想碰撞后,我感觉计算机视觉在生活中几乎无处不在。引用第一天简报的话语:计算机视觉将会应用到我们的汽车,我们的家庭,我们的搜索引擎,我们的医院等等各种各样的领域中。它可以用来帮助那些有残疾的人士,可以分析社交关系,可以用来拯救垂危的生命,可以用来增加粮食的产量等等。而计算机视觉要实现这样的目标,需要来自于各个不同领域具有各种专业背景的研究员。”

CVPR论文是如何写成的

今年的最佳学生论文毫不意外也是关于深度学习的文章,来自康奈尔团队的关于Spatio-Temporal Graph上的深度学习工作:Structural-RNN:Deep Learning on Spatio-Temporal Graphs, Ashesh Jain, Amir R,Zamir, Silvio Savarese, Ashutosh Saxena。最佳论文第二名(Honorable Mention) 则颁给了慕尼黑科大(TUM)团队关于优化理论的文章:Sublabel-Accurate Relaxation of Nonconvex Energies, Thomas Möllenhoff, Emanuel Laude, Michael Moeller, Jan Lellmann, Daniel Cremers。 可见组委会在疯狂的深度学习热潮中依然保持着对传统能量优化问题的重视。其中一个重要原因可能是,尽管深度神经网络在中高层视觉中已所向披靡,但其在底层视觉的一些问题中仍未超越传统方法,例如去噪、光流、以及立体视觉匹配。

该论文中TUM Cremers团队提出的优化方法正是针对低层视觉问题中的经典formulation:逐像素的非凸数据项 TV正则化约束。该方法的中心思想是对每一个像素而言,用一个高维向量(Lifted Representation)来表示原问题中要优化的标量(或低维)自变量,将原问题映射到一个更高维空间中的一个等价问题,从而可以对非凸能量项进行更好的凸近似,获得更高的解的质量。近似后得到的凸能量可以并行优化,且易于实现,可以高效地找到近似问题的全局最优解。论文重点讨论了该方法在立体视觉匹配中的应用,效果大大超过了传统的TV 非凸数据项的解法。

张弛同学解释:“立体视觉匹配是我的研究重点之一,该问题的任务是从双目相机所获取的左眼图像和右眼图像中恢复出逐像素点的深度。由于双目相机中的平行极线约束,该问题又转化为左右眼图之间的逐像素匹配问题。”

受限于训练数据的数量,同时也因为可能未找到该问题下的最佳网络结构,深度学习中的端到端的训练方法在立体视觉匹配上的表现依然未超过传统方法。这里的端到端的训练方法指的是:直接对输入图片进行一些列卷积以及一些列反卷积来回归出输出图像。由于获得双目图像的ground truth深度数据本身就是一个难题,目前立体视觉匹配两个主要benchmark Middlebury和KITTI上也分别只有数十对和数百对的训练数据,对训练端到端的深度估计网络还远远不够。

为了解决这个难题,TUMCremers团队在另一篇论文中讨论了如何生成足够且靠谱的训练数据用以训练深度估计网络:A Large Dataset to Train Convolutional Networks for Disparity, Optical Flow, and Scene Flow Estimation, Nikolaus Mayer, Eddy Ilg, Philip Häusser, Philipp Fischer,Daniel Cremers, Alexey Dosovitskiy, Thomas Brox。该论文使用开源的3D Creation Suite Blender渲染出一系列带有复杂运动模式的物体的双目图片,由于渲染过程是从3D到2D且物体及场景的三维模型已知,生成ground truth的深度图变得非常容易。生成的训练数据集中包含35,000对训练样本,训练得到的深度估计网络在KITTI上的排名也比较靠前,但离第一名传统方法Displet仍有相当一段距离。这里值得一提的是,虽然该网络使用人工合成的数据集进行训练,它在真实数据集上似乎具有良好的泛化能力。随着训练数据的不断完善,深度网络在几个重要的低层视觉问题上是否会超越以及如何超越传统方法,又或者能给传统解法带来什么样的启发,我们拭目以待。

张弛还分享了他们组关于物体扫描方面的工作——Joint Multiview Segmentation and Localization of RGB-D Images Using Depth-Induced Silhouette Consistency论文的准备历程。“CVPR的主会议程非常紧凑,被接收的600多篇论文被安排在短短四天里面完成展示。我们的工作在29号下午进行展示。该工作由中山大学智能信息处理实验室以及微软亚洲研究院多媒体搜索与挖掘组共同合作完成。论文的动机为利用物体的剪影信息来提高RGB-DSLAM中相机位置估计的精度。由于物体剪影难以获得,一般需要繁琐的用户输入,这大大阻碍了使用剪影信息的系统的实用性。针对这个问题,我们提出同时进行多视角物体分割以及相机定位的解决方案,使得物体剪影可以在优化过程中即时产生,并用于改进相机姿态估计。论文的实验中展示了所提出方法产生的更高质量的重建结果。”张弛说。

从ImageNet比赛冠军到CVPR最佳论文

微软亚洲研究院在深度舞台中继续扮演重要角色,2015年12月在ImageNet图像识别挑战赛上开创152层神话的Deep Residual Networks夺得了最佳论文奖!其实这一结果计算机视觉组的研究员们表示并没有感到十分意外,去年的ImageNet& Microsoft COCO比赛他们正是凭借着该方法获得了全部5个主要项目的冠军。在方法公布后至今的半年多的时间里,该方法在学术界和工业界受到了较大的关注,之后的许多成果从不同的侧面印证了该模型的有效性。这次获奖再次印证了学术界对这项工作的肯定。随着神经网络层数加深,神经网络会变得越来越难训练。论文提出了一种针对深度神经网络的残差训练框架,解决了这一当前具有迫切需求的难题。

张祥雨同学作为这篇文章的作者之一,他的研究方向主要为深度网络模型构建及其在图像分类问题上的应用。他认为:“由于该方向在深度视觉领域的基础性,优秀的工作往往会得到学术界的高度重视,当然也意味着相对较大的研究难度。”

张祥雨分享道:“作为该项工作的参与者之一,我从中学到了很多。该项研究始于去年5月左右。一次偶然的机会,我发现某些含有跨层结构的网络能够很大程度上提升网络的深度,同时模型的分类精度也有大幅提高。沿着这个思路走下去,我们得到了一系列结构复杂但是性能良好的模型。然而此时指导老师指出这条思路是不正确的,复杂的模型包含了太多的参数,使得我们很难在多个任务上公平地衡量模型的优劣;更重要的是,由于模型的复杂性,我们无法得知究竟是哪一块设计对最终结果起到了决定性的作用,从而难以对以后的工作产生有益的指导。因此老师建议对当前的模型结构进行简化,只保留对最终精度影响最大的结构成分。起初我对此十分不解,因为模型结构的简化通常是以损失精度为代价的,尤其是当时随着比赛日期的临近,“追求极致精度”似乎是更为合理的做法。然而事实证明指导老师是正确的,当我们对网络结构进行充分的简化和变形之后,我们发现模型中的残差结构对网络性能起到了决定性的影响,而跨层的设计则避免了传统深层网络中常见的梯度消失或膨胀的问题。至于简化模型所损失的精度,可以简单地通过增加网络深度来补偿。后来的实验表明,这种极简的网络设计在保证分类精度的同时,极大地方便了模型在物体定位、物体检测、图像分割等问题中的运用。这也使得我们在去年ImageNet& COCO比赛中在不同的项目上均取得了较大优势。”

作者分享

张弛:

在微软亚洲研究院实习的过程中,不仅可以得到世界级水平的指导,还能接触到领域各路武林高手,快速地了解前沿科技的动态。研究院的各位老师和同学都非常nice,大家工作都非常认真,同时也玩得很认真。Work hard, play harder。在这里实习不仅开拓了计算机领域的眼界,也是生活中的难忘经历。

张婷:

在这里实习的过程中,在每一次讨论中,我都受益良多,感受到其正确对待科研的态度,对问题深刻的洞察力,以及始终保持对科研的好奇心。同时,在研究院还能接触到各种研究方向的大牛们,听到计算机领域里最前沿的讲座,参加各种各样好玩的Party,在收获知识、收获成长的同时也获得了快乐。

张祥雨:

我刚来到微软的时候恰逢我们深度视觉小组刚刚组建之时,我很荣幸地成为了这个小组的一员。三年来我亲身体会了我们小组的发展,从刚开始的一篇空白,逐渐发展为具有世界水平的研究团队,完成了诸如首次在图像分类问题上超越人类水平、获得ImageNet比赛冠军等一系列重大突破。身处微软亚洲研究院视觉计算组,我感受到了一种强大的学术精神,身边的所有人无论过去取得的成绩如何,面对深度学习这样一个快速发展的领域,他们每时每刻都在学习,都在进步。而导师们面对全新的领域仍然能保持敏锐的学术嗅觉,把握正确的科研方向,在紧随科研前沿的同时却不失学者的严谨与谦逊,所有这些均对我触动很大。

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)