重磅!独家解密腾讯AR开放平台“QAR”!| SIGGRAPH Asia 2016

腾讯AR研究员刘骁

12月6日,SIGGRAPH Asia 2016正在澳门举行,今年有相当一部分内容都与VR/AR有关。今天,在腾讯优图实验室、清华大学-腾讯联合实验室以及腾讯AI Lab联合举行的一场分享会议中,来自腾讯的刘骁首次介绍了腾讯“QAR开放平台”,一个增强现实平台。

在腾讯从事AR研究超过3年的刘骁告诉雷锋网 (公众号:雷锋网) ,该平台目前还没有对外推出,预计会在明年随其它产品一并发布。

以下内容整理自刘骁的Keynote演讲。

AR背景

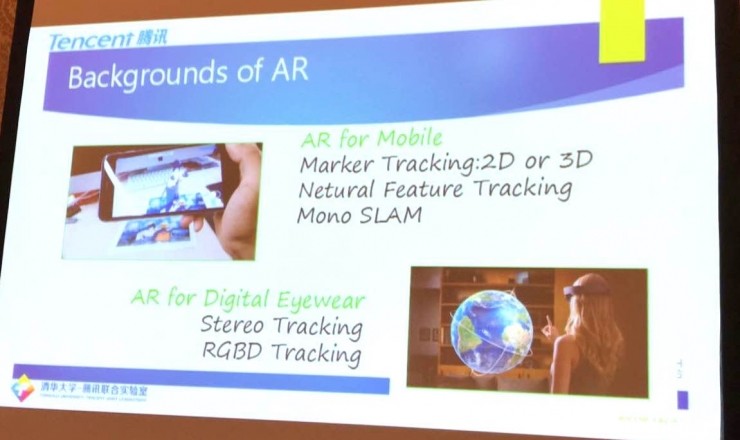

近些年AR领域越来越火,特别是在广告和游戏等领域。当前的AR可以分为两种:一种是移动AR,另一种是头戴显示器。由于它们使用的传感器不同,通常其追踪技术也不同。

对于希望开发AR应用的开发者来说,目前比较流行的AR SDK有Vuforia、ARToolkit、Metaio和Wikitude。而app开发者遇到的问题是:

1、一些强大的API对入门开发者来说太难了;

2、对轻量级App来说过重;

3、模型渲染需要额外工作;

4、建立识别服务需要额外的工作;

5、一些前沿的功能没有包括进来:SLAM,室外脸部AR等等。

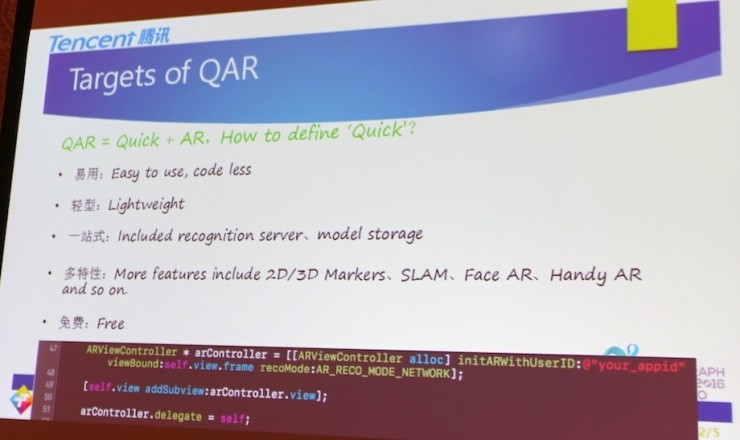

QAR

QAR=Quick+AR,其目标是构建易用、轻型、一站式、多特性并且免费的AR SDK,开发者只需要3行代码就能为自己的App加入腾讯的AR模块功能。

对“Quick”的定义:

易用:容易使用,代码少;

轻型:轻量;

一站式:包含识别服务、模型存储;

多特性:包含2D/3D Markers、SLAM、Face AR、Handy AR等功能;

免费。

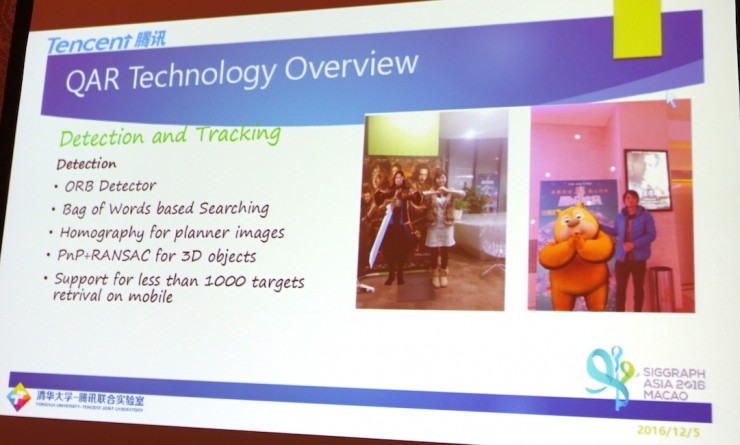

现场视频演示了四个Demo,分别是:The Smurfs 2和NARUTO的3D动画Demo,The Avengers AR预告片Demo,以及和真实3D模型合影的AR相机Demo。

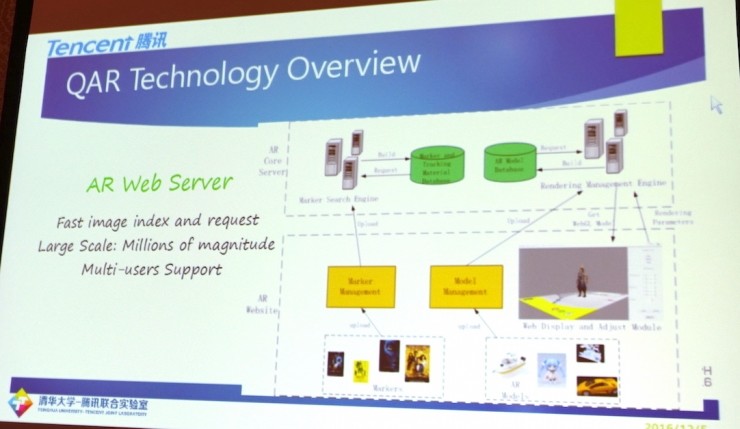

QAR技术概述

AR网络服务器

首先,我们建立了一个AR网络服务器,用于图像队列和模型管理(Image Queue and Model Management)。用户与AR数据库的交互分两步,首先是上传Marker图像到服务器,然后服务器会对其进行识别,并将AR模型调整后与之匹配,然后进行显示。整个过程非常迅速,且支持多用户和巨大用户规模,每个用户有自己的数据库。

图像和目标检索方面,我们使用了CDVS(Compact Descriptors for Visual Search)算法。

探测和追踪

探测追踪是AR技术里的核心,在探测方面,我们使用了ORB探测器,基于一般采用词集(bags of words)方法的搜索,针对二维图像使用Homography,三维图像则是PnP+RANSAC。这使得我们在移动平台上支持低于1000个目标的检索。

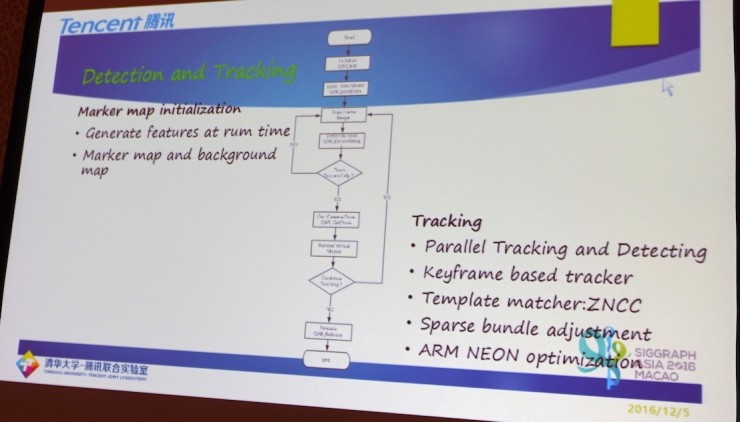

下面这张图是我们追踪方案的技术实现过程,我们使用基于SLAM的追踪技术,因为希望同时支持目标和场景追踪,所以我们也要做Mapping。

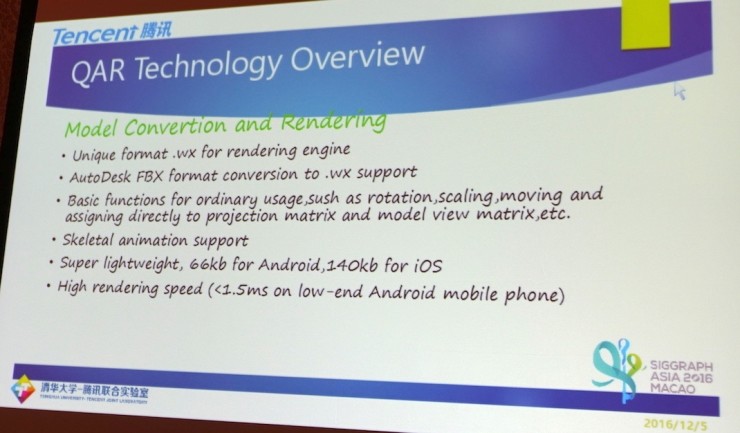

模型转换和渲染

在模型渲染方面我们使用了基于Open GL ES的轻量级引擎,Android只需66kb,iOS为140kb。同时拥有很高的渲染速度,在低端的Android手机上小于1.5ms。

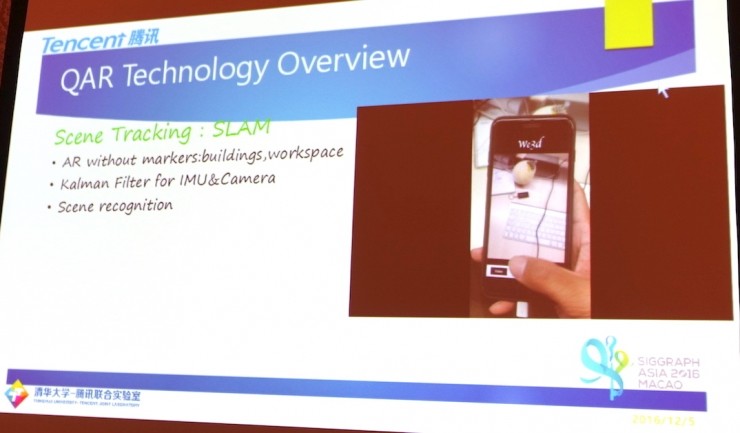

场景追踪:SLAM

对于建筑、办公场所等地,我们有不需要Marker点的SLAM追踪技术。同时,我们采用了Kalman过滤器将IMU和相机的数据融合到一起,提供快速和稳定的追踪。

QAR应用

QAR还没有对外发布,但腾讯内部已经有一些应用对这个平台非常感兴趣了,下面就分享一些应用场景。

QAR应用:

1、微信电影票;

2、RTX+Tencent Explorer;

3、QQ手机浏览器;

4、KM

5、微信公开课;

6、微信扫一扫;

7、手机管家;

8、应用宝。

以微信电影票为例,用户可以在App里打开摄像头对准海报,比如热门电影《天将雄师》,之后3D的成龙就会跳出来,用户可以和他合影交分享到朋友圈。

目前我们正与内部许多应用一起探索AR的应用场景,正在合作的项目包括:RTX+Tencent Explorer、微信、QQ浏览器、手机管家和应用宝。

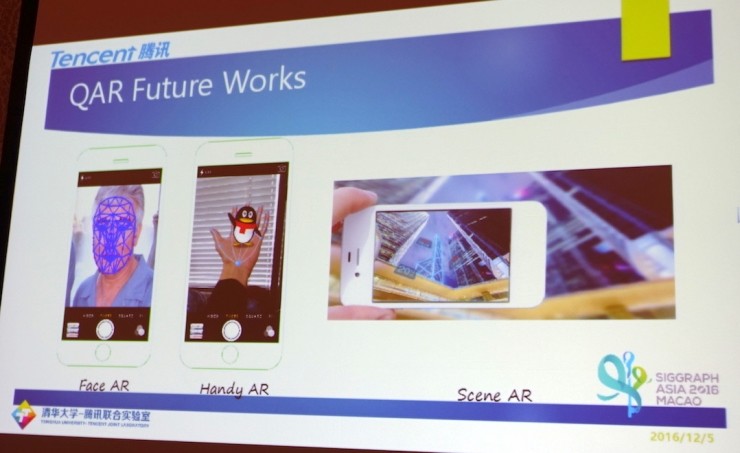

QAR的未来方向

除了已有的目标追踪功能,未来我们还将在QAR SDK中加入另外三项功能:Face AR、Handy AR和Scene AR。

除了针对App开发者,我们还将为网页开发者推出H5开放平台。再往后,我们希望对各种头戴显示器进行支持,包括HoloLens、Meta等。

开发者若想了解QAR,可以访问 www.aropen.com 。

雷锋网原创文章,未经授权禁止转载。详情见 转载须知 。

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)