牙膏时代结束!Intel发布全新Sunny Cove架构,最快2019年下半年面世

雷锋网 (公众号:雷锋网) 消息,北京时间12月12日晚,在圣克拉拉举办的架构日活动上,Intel高级副总裁兼硅工程师集团总经理Jim Keller公开展示了一系列处于研发中的基于10nm的系统,将用于PC、数据中心和网络设备,并预览了其他针对更广泛工作负载的技术,其中最吸引人的便是基于10nm的 下一代“Sunny Cove”处理器架构 。

据悉,Sunny Cove架构旨在提高通用计算任务下每时钟计算性能和降低功耗,并包含了可加速人工智能和加密等专用计算任务的新功能。明年晚些时候,Sunny Cove将成为Intel下一代PC和服务器处理器的基础架构。

Sunny Cove能够减少延迟、提高吞吐量,并提供更高的并行计算能力,有望改善从游戏到多媒体到以数据为中心的应用体验,其功能特性包括:

-

增强的微架构,可并行执行更多操作。

-

可降低延迟的新算法。

-

增加关键缓冲区和缓存的大小,可优化以数据为中心的工作负载。

-

针对特定用例和算法的架构扩展。例如,提升加密性能的新指令,如矢量AES和SHA-NI,以及压缩/解压缩等其它关键用例。

同时,Intel首席架构师、核心与视觉计算集团高级副总裁兼边缘计算解决方案总经理Raja Koduri向大家介绍了全新的 Gen 11核心显卡 ,并重申了在2020年推出独立图形处理器的计划。

Gen 11核心显卡将于2019年开始随10nm处理器一同面世,配备64个EUs(增强型执行单元),运算规模是此前Gen 9核心显卡的2倍,浮点运算性能超过1TFlops,并采用Intel自适应同步技术,旨在提高游戏的可玩性。该显卡还将采用业界领先的媒体编码器和解码器,在有限的功耗下支持4K视频流和8K内容创作。

此外,Intel还在活动上介绍了傲腾技术、Foveros逻辑芯片3D堆叠技术、One API软件以及深度学习参考堆栈等内容。

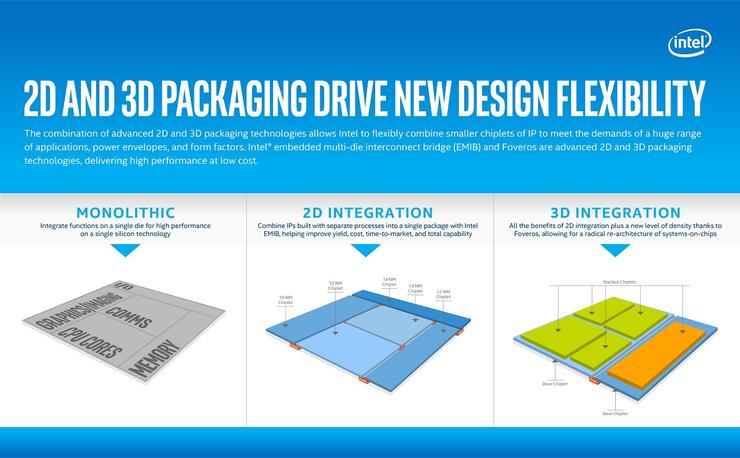

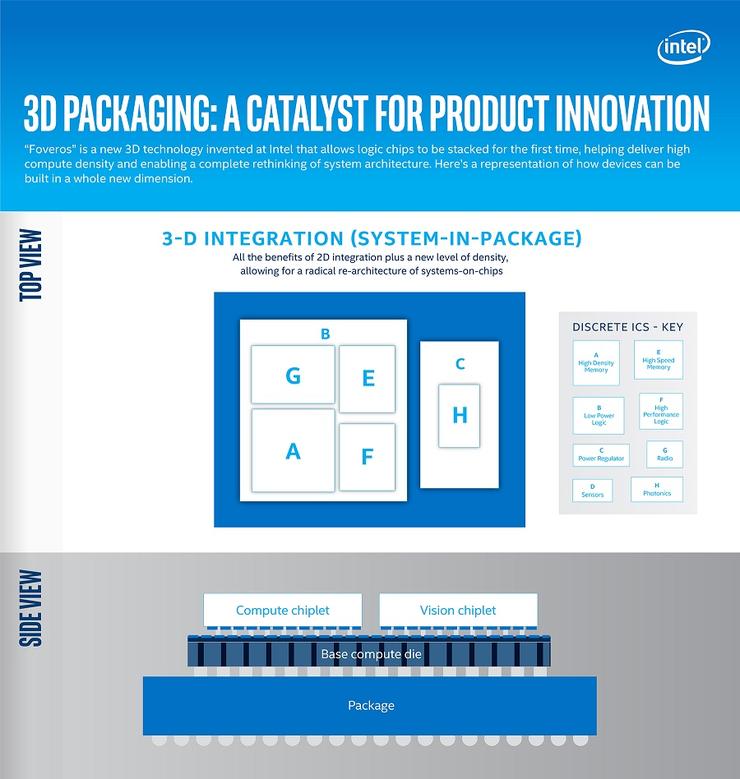

逻辑芯片3D堆叠技术:继2018年英特尔推出EMIB(嵌入式多芯片互连桥接)2D封装技术之后,Intel此次展示了业界首创的名为Foveros的全新逻辑芯片3D堆叠技术,可实现在逻辑芯片上堆叠逻辑芯片。

该技术有望首次将晶片的堆叠从传统的无源中间互连层和堆叠存储芯片扩展到CPU、GPU和AI处理器等高性能逻辑芯片,为整合高性能、高密度和低功耗硅工艺技术的器件和系统铺平了道路。设计人员可在新的产品形态中“混搭”不同的技术专利模块与各种存储芯片和I/O配置。并使得产品能够分解成更小的“芯片组合”,其中I/O、SRAM和电源传输电路可以集成在基础晶片中,而高性能逻辑“芯片组合”则堆叠在顶部。

Intel预计将从2019年下半年开始推出一系列采用Foveros技术的产品。首款Foveros产品将整合高性能10nm计算堆叠“芯片组合”和低功耗22FFL基础晶片。它将在小巧的产品形态中实现世界一流的性能与功耗效率。

One API软件:Intel宣布推出“One API”项目,以简化跨CPU、GPU、FPGA、人工智能和其它加速器的各种计算引擎的编程。该项目包括一个全面、统一的开发工具组合,以将软件匹配到能最大程度加速软件代码的硬件上。公开发行版本预计将于2019年发布。

傲腾技术:Intel傲腾数据中心级持久内存作为一款新产品,集成了内存般的性能以及数据的持久性和存储的大容量。这项技术通过将更多数据放到更接近CPU的位置,使应用在人工智能和大型数据库中的更大量的数据集能够获得更快的处理速度。其大容量和数据的持久性减少了对存储进行访问时的时延损失,从而提高工作负载的性能。

Intel傲腾数据中心级持久内存为CPU提供缓存行(64B)读取。一般来说,当应用把读取操作定向到傲腾持久内存或请求的数据不在DRAM中缓存时,傲腾持久内存的平均空闲读取延迟大约为350ns。如果实现规模化,傲腾数据中心级固态盘的平均空闲读取延迟约为10000ns(10μs),这将是显著的改进。在某些情况下,当请求的数据在DRAM中时,不管是通过CPU的内存控制器进行缓存还是由应用所引导,内存子系统的响应速度预计与DRAM相同(小于100 ns)。

Intel还展示了傲腾与QLC固态硬盘的结合,将降低对最常用数据的访问延迟。总体来说,这些对平台和内存的改进重塑了内存和存储层次结构,从而为系统和应用提供了完善的选择组合。

深度学习参考堆栈(Deep Learning Reference Stack):这是一个集成、高性能的开源堆栈,基于Intel至强可扩展平台进行了优化。该开源社区版本旨在确保人工智能开发者可以轻松访问Intel平台的所有特性和功能。深度学习参考堆栈经过高度调优,专为云原生环境而构建。该版本可以降低集成多个软件组件所带来的复杂性,帮助开发人员快速进行原型开发,同时让用户有足够的灵活度打造定制化的解决方案。

-

操作系统:Clear Linux 操作系统可根据个人开发需求进行定制,针对Intel平台以及深度学习等特定用例进行了调优;

-

编排:Kubernetes可基于对Intel平台的感知,管理和编排面向多节点集群的容器化应用;

-

容器:Docker容器和Kata容器利用Intel虚拟化技术来帮助保护容器;

-

函数库:Intel深度神经网络数学核心函数库(MKL DNN)是Intel高度优化、面向数学函数性能的数学库;

-

运行时:Python针对Intel架构进行了高度调优和优化,提供应用和服务执行运行时支持;

-

框架:TensorFlow是一个领先的深度学习和机器学习框架;

-

部署:KubeFlow是一个开源、行业驱动型部署工具,在Intel架构上提供快速体验,易于安装和使用。

雷锋网原创文章,未经授权禁止转载。详情见 转载须知 。

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)