视觉问答领域又一力作!斯坦福大学教授发布图像场景图问答数据集 GQA

雷锋网 AI 科技评论: GQA 是斯坦福大学教授 Christopher Manning 及其学生 Drew Hudson 一同打造的全新图像场景图问答数据集,旨在推动场景理解与视觉问答研究领域的进步。

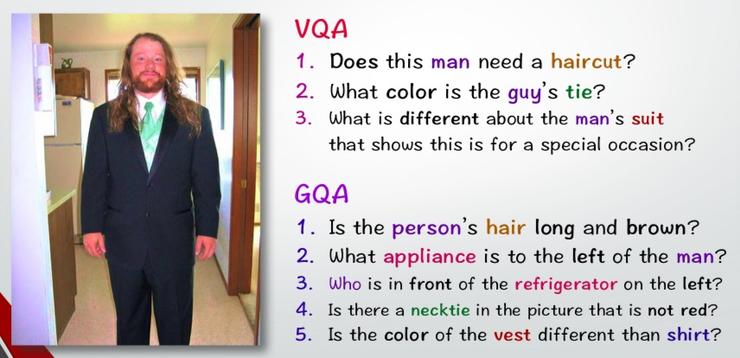

据 Christopher Manning 教授及其学生 Drew Hudson 调查后发现,现有的视觉问答数据集主要存在两种缺陷:一个是 基准失误 ,当中包括了基于语言先验的偏见、视觉偏见、过分关注显着对象、来源有误、对象缺位、答案不合逻辑、模型反应不一致等;一个是 推理数据集的数量很有限 。

为此,他们开发了一个用于对现实世界的图像进行视觉推理与综合回答的全新数据集 GQA,该数据集包含高达 20M 的各种日常生活图像,主要源自于 COCO 和 Flickr。 每张图像都 与图中的物体、属性与关系的场景图(scene graph)相关 ,创建上基于最新清洁版本的 Visual Genome。此外, 每个问题都与其语义的结构化表示相关联,功能程序上指定必须采取一定的推理步骤才能进行回答。

GQA 数据集的许多问题涉及多种推理技巧、空间理解以及多步推理,比起人们先前常用的视觉回答数据集,更具有挑战性。他们保证了数据集的平衡性,严格控制不同问题组的答案分布,以防止人们通过语言和世界先验知识进行有据猜测。

最后,他们通过一套全新的指标来完善数据集,该指标不仅能测试模型的精确度,还可预测模型响应的一致性、有效性于合理性,从而帮助我们更了解模型背后的运作原理。虽说问题是自动生成的,但由于生成主要基于自然语言众包场景图,因此在语法性、多样性和惯用性上将有所保障。

为了鼓励更多人尝试使用 GQA 数据集,他们将从 2019 年 2 月 开始举办相关比赛。他们希望 GQA 成为开发更强大和更有说服力的推理模型的关键助力,进而推动场景理解与视觉问答研究领域的进步。

via https://cs.stanford.edu/people/dorarad/gqa/download.html

雷锋网 (公众号:雷锋网) AI 科技评论 雷锋网

雷锋网原创文章,未经授权禁止转载。详情见 转载须知 。

原文 https://www.leiphone.com/news/201901/XApZvOPfG6xAxFRT.html

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)