SpringBoot使用ELK日志收集

在之前写过一篇文章介绍ELK日志收集方案,感兴趣的可以去看一看,点击这里----->《ELK日志分析方案》。

这里在对ELK做一下简述,ELK是有Elastic公司的三个组件配合进行日志收集,分别是:

- ElasticSearch:用于存储日志信息。

- Logstash:用于收集、处理和转发日志信息。

- Kibana:提供可搜索的Web可视化界面。

当然,现在很多都配合着Beats进行使用,这里不做过多描述,感兴趣的可以查看官网, www.elastic.co/cn/products… ,这里有很多对Beats的描述。

1.2 安装

有关ELK安装笔者之前都写过关于Linux环境下的安装,如下:

- 《Linux安装Elasticsearch》

- 《Linux安装Logstash》

- 《Linux安装Kibana》

其他环境安装方式类似,基本上都是下载压缩包解压这一套流程。

2.SpringBoot日志输出到Logstash

这里以logback日志为例,新建项目,在项目中加入logstash-logback-encoder依赖,完整pom如代码清单所示。

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.1.2.RELEASE</version>

<relativePath/> <!-- lookup parent from repository -->

</parent>

<groupId>com.dalaoyang</groupId>

<artifactId>springboot_logstash</artifactId>

<version>0.0.1-SNAPSHOT</version>

<name>springboot_logstash</name>

<description>springboot_logstash</description>

<properties>

<java.version>1.8</java.version>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

<scope>runtime</scope>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>5.3</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

</plugin>

</plugins>

</build>

</project>

复制代码

接下来新建一个logback-spring.xml文件,配置logback日志信息,注意这里配置的destination属性,输出的要和logstash配置的对应上,不然收集不上,内容如下:

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<include resource="org/springframework/boot/logging/logback/base.xml" />

<appender name="LOGSTASH" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>127.0.0.1:4560</destination>

<!-- 日志输出编码 -->

<encoder charset="UTF-8"

class="net.logstash.logback.encoder.LoggingEventCompositeJsonEncoder">

<providers>

<timestamp>

<timeZone>UTC</timeZone>

</timestamp>

<pattern>

<pattern>

{

"logLevel": "%level",

"serviceName": "${springAppName:-}",

"pid": "${PID:-}",

"thread": "%thread",

"class": "%logger{40}",

"rest": "%message"

}

</pattern>

</pattern>

</providers>

</encoder>

</appender>

<root level="INFO">

<appender-ref ref="LOGSTASH" />

<appender-ref ref="CONSOLE" />

</root>

</configuration>

复制代码

修改启动类,加入一个mvc方法,主要用于输出日志,如下所示。

package com.dalaoyang;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController;

@SpringBootApplication

@RestController

public class SpringbootLogstashApplication {

Logger logger = LoggerFactory.getLogger(SpringbootLogstashApplication.class);

@GetMapping("test")

public void test(){

logger.info("测试初始一些日志吧!");

}

public static void main(String[] args) {

SpringApplication.run(SpringbootLogstashApplication.class, args);

}

}

复制代码

3.Logstash配置

logstash配置如下,再次提醒一下,输入要与刚刚配置的对应上,输出为本地es:

input {

tcp {

mode => "server"

host => "0.0.0.0"

port => 4560

codec => json_lines

}

}

output {

elasticsearch {

hosts => "localhost:9200"

index => "springboot-logstash-%{+YYYY.MM.dd}"

}

}

复制代码

4.测试

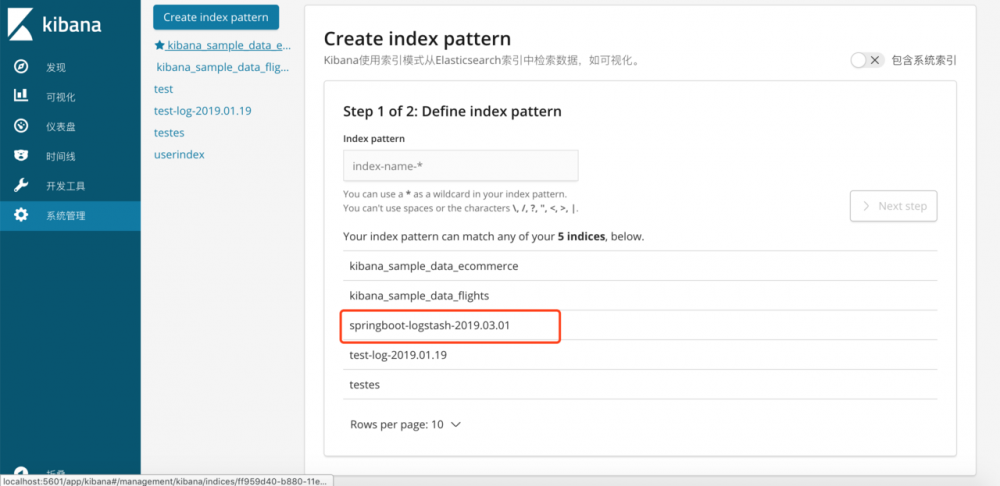

打开kibana管理页面,添加刚刚创建的索引,如图所示。

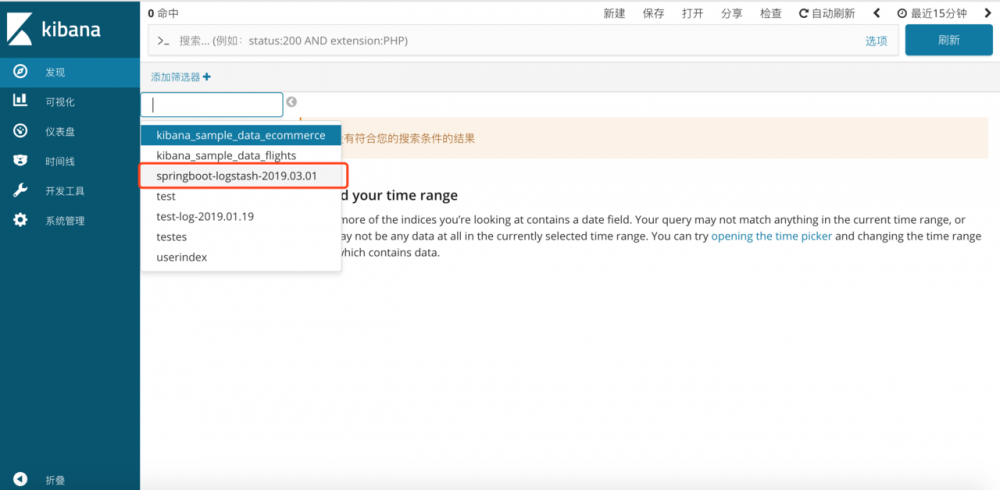

然后进入发现页,选择刚刚的索引,如下所示。

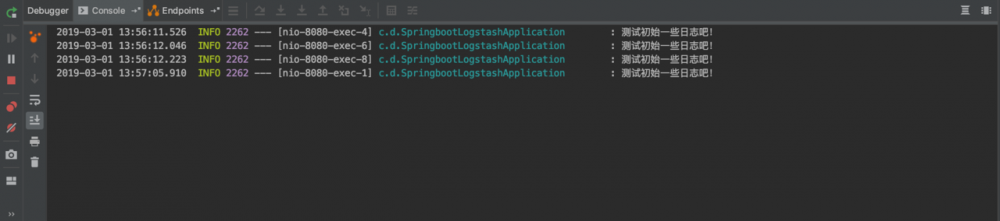

接下来在浏览器多次访问刚刚在项目中输出日志的方法,查询控制台,如下所示。

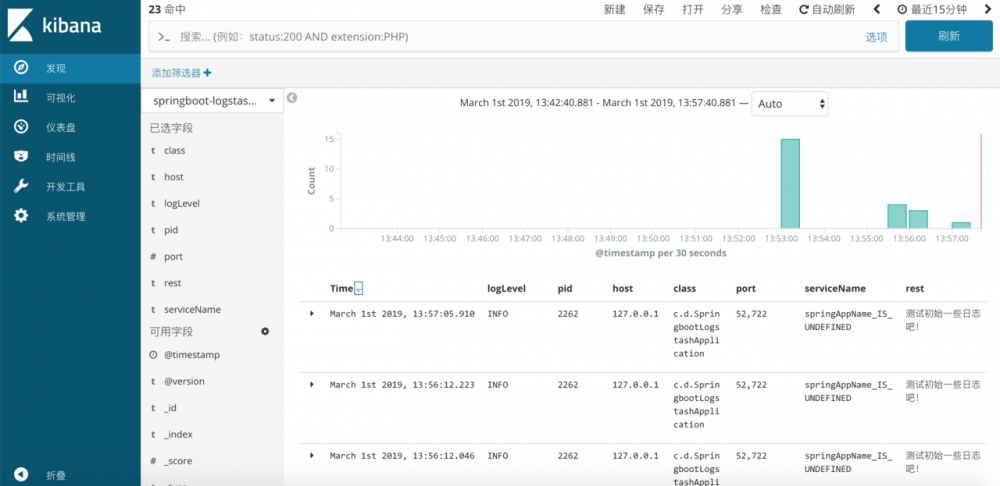

然后在进入kibana查看,不光是日志内容,还有自定义的属性也显示出来了。

正文到此结束

- 本文标签: map CTO build plugin Logback linux pom TCP schema Service 索引 maven cat 代码 provider message Kibana 测试 description 管理 dependencies Logging ELK root tar IDE REST 下载 Elasticsearch web UI XML 文章 springboot apache js 配置 json http id java https 安装 App src IO UTC spring ip

- 版权声明: 本文为互联网转载文章,出处已在文章中说明(部分除外)。如果侵权,请联系本站长删除,谢谢。

- 本文海报: 生成海报一 生成海报二

热门推荐

相关文章

Loading...

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)