一步一图,带你了解分布式架构的前世今生!

还没关注?

快动动手指!

聊技术、论职场!

为IT人打造一个“有温度”的 狸猫技术窝

目录:

-

什么是分布式架构?

-

分布式架构的演进

-

分布式服务面临的问题

什么是分布式架构?

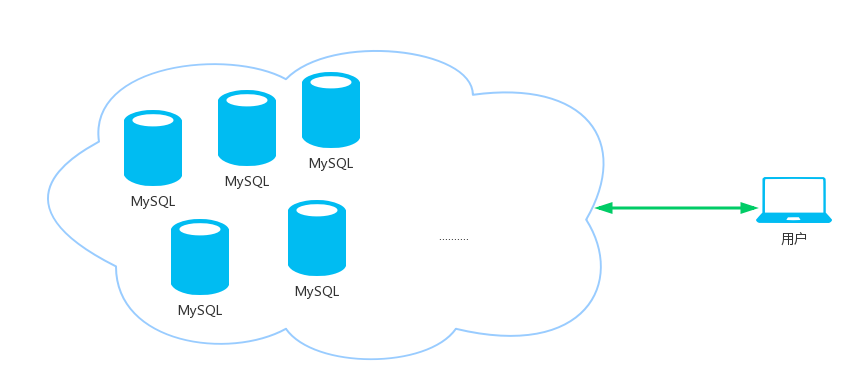

分布式系统(distributed system)是建立在网络之上的软件系统,它有两个典型特点:

-

内聚性 :每个数据库分布节点高度自治,有本地的数据库管理系统

-

透明性 :每个数据库分布节点对用户的应用来说都是透明的,看不出是本地还是远程。

也就是说,在分布式系统中,用户感觉不到数据是分布式的,不知道数据是否分割,有无副本,不知道数据存在于哪个节点上。

简单来说:一个分布式系统中,一组独立的计算机展现给用户的是一个统一的整体,就好像是一个系统似的。

如上图所示,分布式系统作为一个整体对用户提供服务,而整个系统的内部的协作对用户来说是透明的,用户就像是指使用一个mysql 一样。

分布式架构的演进

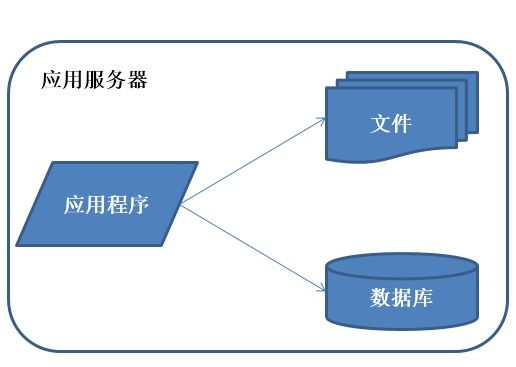

(1)初始阶段架构

特征 :应用程序,数据库,文件等所有资源都放在一台服务器上。

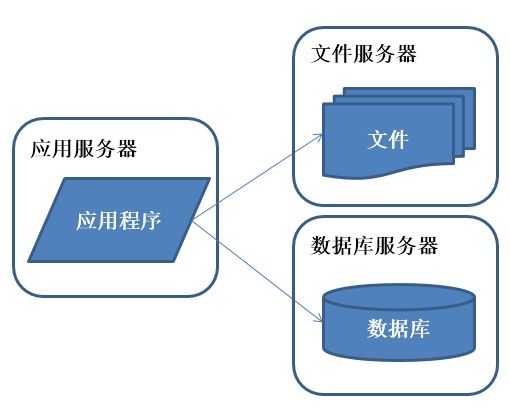

(2)应用服务、数据服务、文件服务分离

说明 :好景不长,随着系统访问量的再度增加,webserver机器的压力在高峰期会上升到比较高,这个时候开始考虑增加一台webserver。

特征 :应用程序、数据库、文件分别部署在独立的资源上。

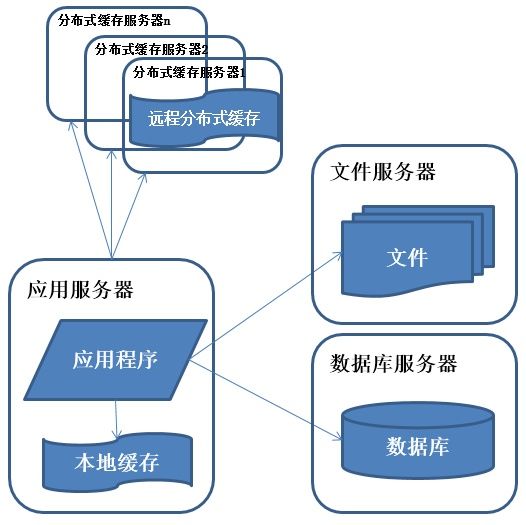

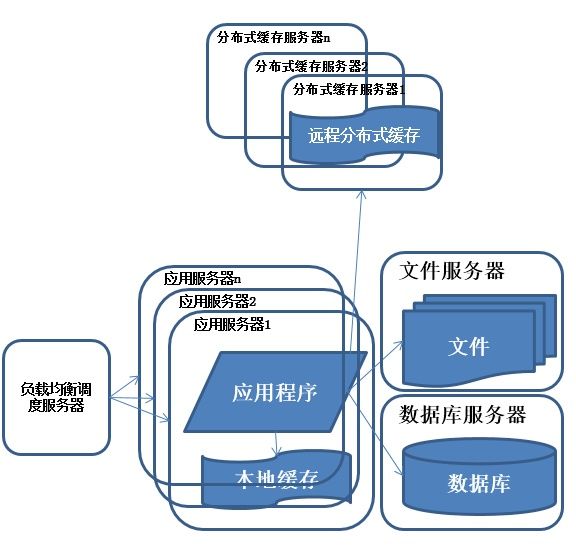

(3)使用缓存改善性能

说明 :系统访问特点遵循二八定律,即80%的业务访问集中在20%的数据上。

缓存分为 本地缓存 和 远程分布式缓存 ,本地缓存访问速度更快但缓存数据量有限,同时存在与应用程序争用内存的情况。

特征 :数据库中访问较集中的一小部分数据存储在缓存服务器中,减少数据库的访问次数,降低数据库的访问压力。

(4)使用“应用服务器”集群

说明 :在做完分库分表这些工作后,数据库上的压力已经降到比较低了,又开始过着每天看着访问量暴增的幸福生活了。

突然有一天,发现系统的访问又开始有变慢的趋势了,这个时候首先查看数据库,压力一切正常,之后查看webserver,发现apache阻塞了很多的请求,

而应用服务器对每个请求也是比较快的,看来是请求数太高导致需要排队等待,响应速度变慢。

特征 :多台服务器通过负载均衡同时向外部提供服务,解决单台服务器处理能力和存储空间上限的问题。

描述 :使用集群是系统解决高并发、海量数据问题的常用手段。通过向集群中追加资源,提升系统的并发处理能力,使得服务器的负载压力不再成为整个系统的瓶颈。

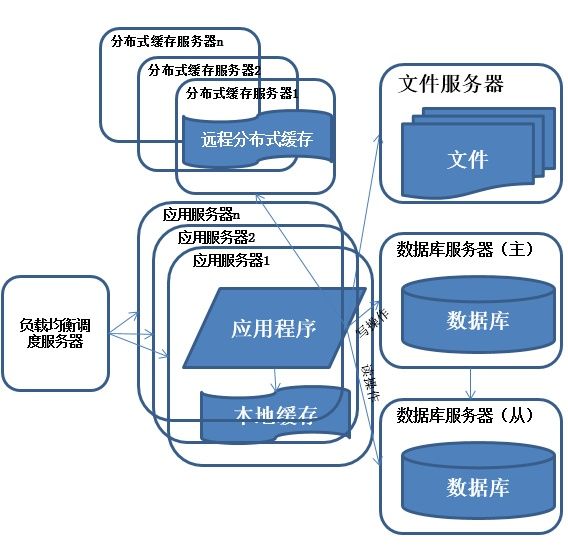

(5)数据库读写分离

说明 :享受了一段时间的系统访问量高速增长的幸福后,发现系统又开始变慢了,这次又是什么状况呢?

经过查找,发现数据库写入、更新的这些操作的部分数据库连接的资源竞争非常激烈,导致了系统变慢

特征 :多台服务器通过负载均衡同时向外部提供服务,解决单台服务器处理能力和存储空间上限的问题。

描述 :使用集群是系统解决高并发、海量数据问题的常用手段。通过向集群中追加资源,使得服务器的负载压力不在成为整个系统的瓶颈。

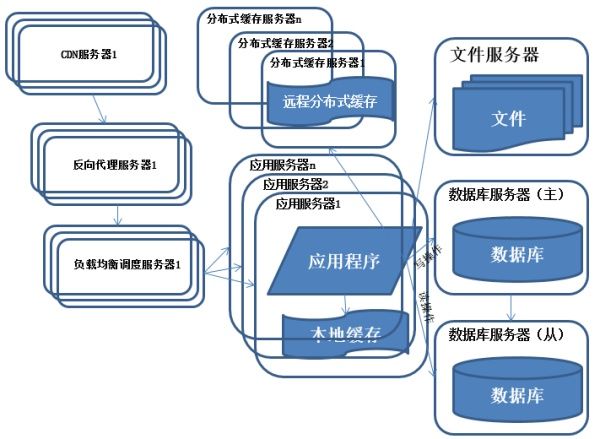

(6)反向代理和CDN加速

:采用CDN和反向代理加快系统的访问速度。

描述

:为了应付复杂的网络环境和不同地区用户的访问,通过CDN和反向代理加快用户访问的速度,同时减轻后端服务器的负载压力。CDN与反向代理的基本原理都是缓存。

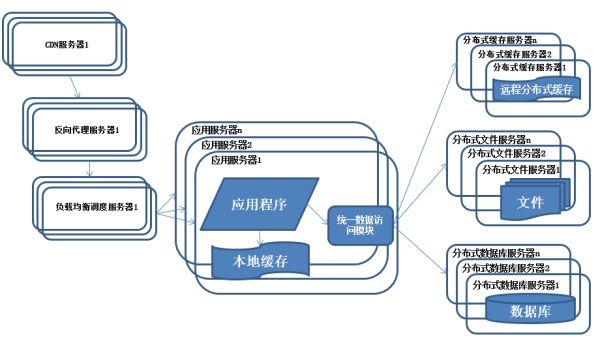

(7)“分布式文件”系统 和 “分布式数据库”

:随着系统的不断运行,数据量开始大幅度增长,这个时候发现分库后查询仍然会有些慢,于是按照分库的思想开始做分表的工作

特征 :数据库采用分布式数据库,文件系统采用分布式文件系统。

描述 :任何强大的单一服务器都满足不了大型系统持续增长的业务需求,数据库读写分离随着业务的发展最终也将无法满足需求,需要使用分布式数据库及分布式文件系统来支撑。

分布式数据库是系统数据库拆分的最后方法,只有在单表数据规模非常庞大的时候才使用,更常用的数据库拆分手段是业务分库,将不同的业务数据库部署在不同的物理服务器上。

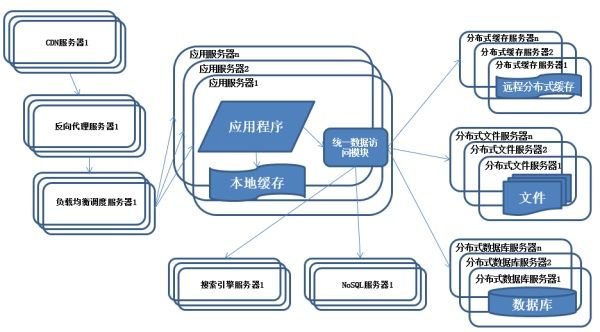

(8)使用NoSQL和搜索引擎

:系统引入NoSQL数据库及搜索引擎。

描述

:随着业务越来越复杂,对数据存储和检索的需求也越来越复杂,系统需要采用一些非关系型数据库如NoSQL和分数据库查询技术如搜索引擎。

应用服务器通过统一数据访问模块访问各种数据,减轻应用程序管理诸多数据源的麻烦。

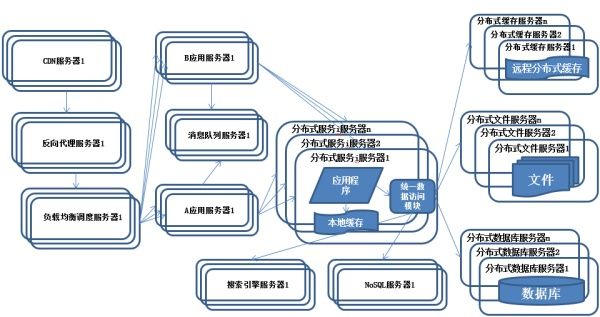

(9)业务拆分

:系统上按照业务进行拆分改造,应用服务器按照业务区分进行分别部署。

描述

:为了应对日益复杂的业务场景,通常使用分而治之的手段将整个系统业务分成不同的产品线,应用之间通过超链接建立关系,也可以通过消息队列进行数据分发,

当然更多的还是通过访问同一个数据存储系统来构成一个关联的完整系统。

纵向拆分 :将一个大应用拆分为多个小应用,如果新业务较为独立,那么就直接将其设计部署为一个独立的Web应用系统

纵向拆分相对较为简单,通过梳理业务,将较少相关的业务剥离即可。

横向拆分 :将复用的业务拆分出来,独立部署为分布式服务,新增业务只需要调用这些分布式服务

横向拆分需要识别可复用的业务,设计服务接口,规范服务依赖关系。

(10)分布式服务

:公共的应用模块被提取出来,部署在分布式服务器上供应用服务器调用。

描述

:随着业务越拆越小,应用系统整体复杂程度呈指数级上升,由于所有应用要和所有数据库系统连接,最终导致数据库连接资源不足,拒绝服务。

分布式服务面临哪些问题?

-

当服务越来越多时,服务URL配置管理变得非常困难,F5硬件负载均衡器的单点压力也越来越大。

-

当进一步发展,服务间依赖关系变得错踪复杂,甚至分不清哪个应用要在哪个应用之前启动,架构师都不能完整的描述应用的架构关系。

-

接着,服务的调用量越来越大,服务的容量问题就暴露出来,这个服务需要多少机器支撑?什么时候该加机器?

-

服务多了,沟通成本也开始上升,调某个服务失败该找谁?服务的参数都有什么约定?

-

一个服务有多个业务消费者,如何确保服务质量?

-

随着服务的不停升级,总有些意想不到的事发生,比如cache写错了导致内存溢出,故障不可避免,每次核心服务一挂,影响一大片,人心慌慌,如何控制故障的影响面?服务是否可以功能降级?或者资源劣化?

End

作者: 清零者

来源:

https://www.cnblogs.com/dump/p/8125539.html

本文版权归作者所有

为您推荐 :

-

如何设计一个百万级用户的抽奖系统?

-

阿里二面:设计一个电商平台积分兑换系统!

-

扎心一问!你凭什么成为top1%的Java工程师?

-

【干货走一波】千万级用户的大型网站,应该如何设计其高并发架构?

-

PK光明顶?江湖上流传的几大消息队列门派,到底有什么本质区别?

-

扒一扒 JVM 的垃圾回收机制,拿大厂offer少不了它!

-

面试阿里?如果对别人开源的Rocket MQ了如指掌,岂不是很加分?

-

百度、腾讯热门面试题:聊聊Unix与Java的IO模型?(含详细解析)

-

35岁的大龄码农们,如何才能不被社会淘汰掉?

-

一步一图,带你走进Netty的世界!

-

想要去阿里面试?你必须得跨过JVM这道坎!

-

你连Nginx怎么转发给你请求都说不清楚,还好意思说自己不是CRUD工程师?

长按下图二维码,即刻关注【 狸猫技术窝 】

阿里、京东、美团、字节跳动

顶尖技术专家 坐镇

为IT人打造一个 “有温度” 的技术窝!

- 本文标签: mysql 质量 网站 数据 解析 开源 MQ 本质 部署 unix 产品 UI HTML 百度 垃圾回收 工程师 分布式文件系统 服务器 压力 配置 空间 参数 IO 模型 并发 Nginx 数据库 NOSQL 时间 快的 cache 分布式系统 反向代理 web sql 需求 美团 http 高并发 缓存 apache CDN 京东 IT人 软件 src 分布式 JVM java 负载均衡 集群 Netty 二维码 dist id 索引 目录 https 搜索引擎 管理 消息队列 文件系统 架构师

- 版权声明: 本文为互联网转载文章,出处已在文章中说明(部分除外)。如果侵权,请联系本站长删除,谢谢。

- 本文海报: 生成海报一 生成海报二

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)