嘘!我看到了你 60 岁的样子!

作者 | 马超

责编 | 胡巍巍

出品 | CSDN(ID:CSDNnews)

近日,笔者在CSDN博客,发布了一篇有关AI换脸的教程,不过令笔者始料未及的是一石激起千层浪,竟然有不少网友留言求所谓一键“脱”衣的教程。

虽然笔者对于技术的滥用深恶痛绝,但技术本身是中性的,并无好坏之分,从而且从上篇博文中也能看到“AI换脸”的门槛越来越低,目前其应用已经发展到任何人都能操作的地步了。

所以想阻止这些滥用的技术,单靠封杀是不起了什么作用的,所以本文就回归到技术本身,带大家盘点一下那些被滥用的AI模型。

也争取能够抛砖引玉帮助大家提供思路,来检测这些被伪造过的视频。

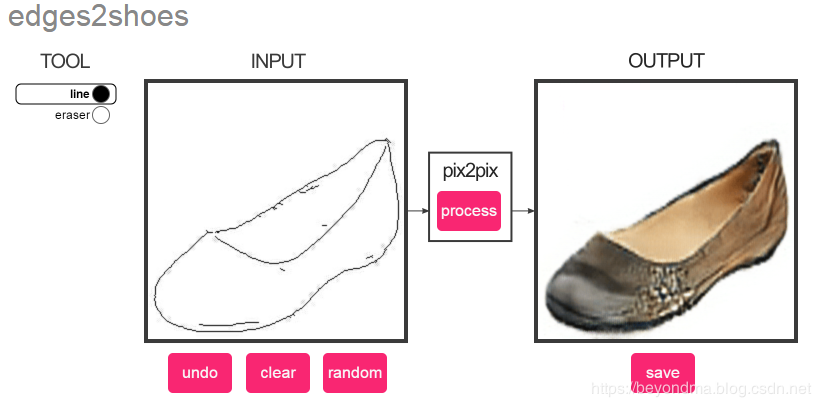

PIX2PIX: AI脑补的先河

鲁迅先生曾说“一见短袖子,立刻想到白臂膊,立刻想到全裸体......中国人的想像惟在这一层能够如此跃进。”不过和AI比起来国人的联想能力根本就是小巫见大巫。

笔者之前的博文AI能让杨超越跳舞,背后原理大揭秘就曾经介绍过PIX2PIX技术,PIX2PIX论文链接,PIX2PIXGithub地址,PIX2PIX是基于对抗神经网络GAN的模型,其目标是由图像的轮廓,还原回真实图像。

目前读者可以到https://affinelayer.com/pixsrv/这个网站来感受一下如何从一个简笔画出的轮廓转换成真实的图像。

后来N厂又提出了PIX2PIXHD技术(GitHub传送门),PIX2PIXHD把之前由PIX2PIX生成的图像分辨率提高了很多。

可以说PIX2PIX是后面这些AI换脸、一键“脱"衣等技术的理论基础,正是凭借AI强大的联想及脑补能力使以上应用成为了可能。

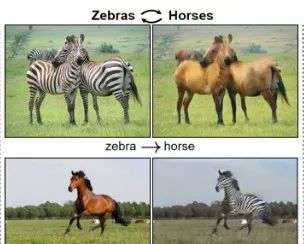

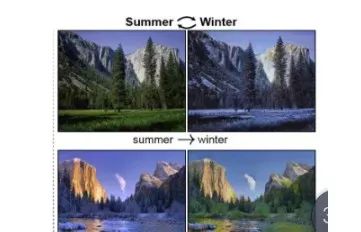

CycleGAN: 指鹿为马的AI

2017年伯克利提出了CycleGAN的理念,CycleGAN论文地址、CycleGAN的Github传送门,CycleGAN使用循环一致性损失函数来实现训练,从而完成将图片中一个域到另一个域的无缝转换。

具体什么是循环一致性损失函数咱们可以找时间详解,简单来说CycleGAN能将图像的主题风格或者某一域主体完美进行切换,具体效果如下:

斑马与马的互转

冬与夏的风格切换

后来NCSOFT又提出了UGATIT,一种加强版的CycleGAN,UGATIT论文地址、Github传送门,其效果更好,具体如下:

CycleGAN出现之后,图像主题无缝切换将图像伪造技术提升了一个高度,在换脸之余还能把原背景主题进行切换,给鉴定带来来大麻烦。

StyleGAN: 能算孩子未来长相的AI

目前好像非常流行组CP,那么N厂提出的StyleGAN就是用来计算Picure A+ Picture B结果的AI,StyleGAN论文地址、StyleGAN的Github传送门,而且他还支持多种结合模式,具体见下表

| Style 等级 |

Picture A |

Picture B |

| 高等级(粗略) |

所有颜色(眼睛,头发,光线)和细节面部特征来自Picture A |

继承Picture B高级的面部特征,如姿势、一般的发型、脸部形状和眼镜 |

| 中等级 |

姿势、一般的面部形状和眼 睛 来自Picture A |

继承Picture B中级的面部特征 ,如发型,张开/闭着的眼睛 |

| 高等级(细微) |

主要面部内容来自Picture A |

继承Picture B高级面部特征,如颜色方案和微观结构 |

其两张图像按照三种Style结合的效果如下图:

Partialconv: 马赛克终结者

Partialconv又是N厂提出的,Partialconv的论文地址、Partialconv的Github传送门,Partialconv其实是PIX2PIX的2.0版本。

即使图像丢失了大面积的像素他也能通过AI将损失进行修复。所谓的一键”去“衣、一键”去“码其实背后都是Partialconv,其效果图如下:

这种修复效果,真的非常惊人。

Speech-Driven Facial Animation: 合成视频的创始人

Speech-Driven Facial Animation是一个由三星提出的使用照片加音频合成视频的模型,SDFA论文地址、SDFA的Github链接,SDA能够仅使用人的静止图像和包含语音的音频剪辑来产生动画面部。

其生成的视频不仅可以产生与音频同步的唇部动作,还可以呈现特有的面部表情,例如眨眼,眉毛等,同时能够捕捉说话者的情绪并将其反映在面部表情中。

原图如下:

SDA处理之后生成的图像,静止图像立刻活灵活现起来。

写在最后

上个月笔者在《银行家杂志》的发文,传统银行如何引领开放银行时代潮流,就曾指出AI换脸等技术的兴起将会我们未来的身份识别及认证造成很大的麻烦。

可以说一旦将人脸面部信息与具体的人联系起来,那么人脸信息就可能被滥用,而且考虑到目前尚没有可靠的技术能够鉴定视频的真伪。

所以笔者这里也以此文号召大家共同关注由脸书、微软联合MIT等科研机构共同发起了”Deepfake挑战赛“,找到以AI破解AI的方法,在而此之前笔者也呼吁各行业按照《GB/T 25724-2017公共安全视频监控数字视音频编解码技术要求》进行安全加固,以防止仿造视频的危害。

作者简介:马超,CSDN博客专家,金融科技从业者。

【END】

热 文推 荐

☞dfuse、慢雾科技、MYKEY共同出席,与你探讨区块链数据架构和项目上链那些事!

☞拍照比剪刀手泄露指纹信息;国内绿 iPhone11 抢断货;PostgreSQL 12 Beta 4 发布 | 极客头条

☞公开课|百度天工物联网基础平台的微服务容器化落地实践

☞惊呆!这辆悍马自己在跑跑跑跑跑跑跑!

☞ 互联网大佬为什么爱唱歌

☞我们到底该如何看待6G?

☞ 大数据工程师手册:全面系统的掌握必备知识与工具

☞ 实操 | 从0到1教你用Python来爬取整站天气网

☞痛!首批共享单车死于2019

点击阅读原文,输入关键词,即可搜索您想要的 CSDN 文章。

你点的每个“在看”,我都认真当成了喜欢

![[HBLOG]公众号](https://www.liuhaihua.cn/img/qrcode_gzh.jpg)